【コスパ最強】次世代の高性能オープンソースLLM「DeepSeek-R1」徹底解説

2025年1月20日、DeepSeekは最新モデル「DeepSeek-R1」の正式リリースを発表しました。

これまで一部の研究者や開発者向けにプレビュー提供されていたモデルが、MITライセンスによってオープンソース化され、誰でも自由に入手・改変・商用利用できるようになっています。

以下、注目のポイントです:

OpenAIのo1相当の推論性能

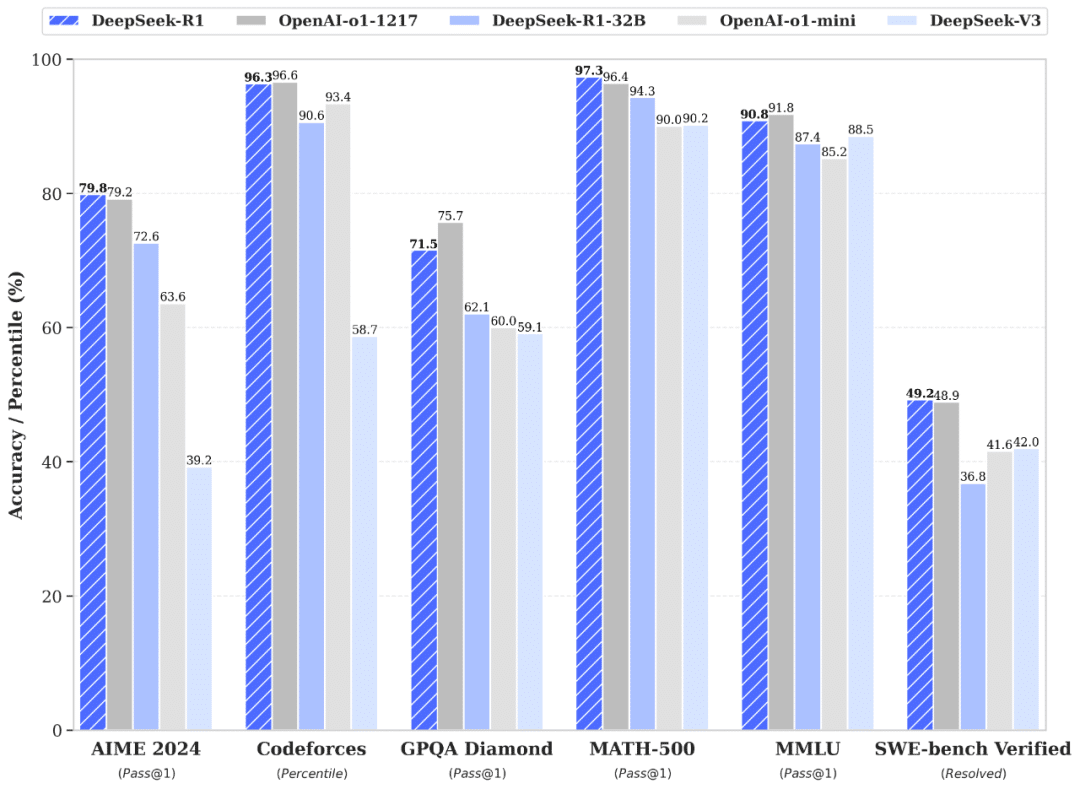

ベンチマーク比較によると、各種数学・プログラミングタスクでOpenAI-o1と同等、もしくはそれ以上の結果が示されています。大型MoE構造で128Kトークンに対応

約671B(推論時37B有効)のパラメータと広大なコンテキストウィンドウを備えています。完全オープンアクセス

コードやモデルの重みがすでに公開されたオープンソースのモデルとなっています。

提供開始時期

今回のリリースでは、モデル本体だけでなく、公式アプリやAPIのアップデートも同時に提供されています。

DeepSeek公式チャットアプリ

ブラウザ版は chat.deepseek.com から利用可能で、画面右上の「DeepThink」ボタンをONしてDeepSeek-R1モデルを利用することができます。

OpenAI互換APIのサポート

DeepSeek側のAPIエンドポイントにおいて model=deepseek-reasoner を指定することで、OpenAI APIと同様の形式でクエリを送信できます。

from openai import OpenAI

client = OpenAI(api_key="<DeepSeek API Key>", base_url="https://api.deepseek.com")

# Round 1

messages = [{"role": "user", "content": "9.11 and 9.8, which is greater?"}]

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=messages

)

reasoning_content = response.choices[0].message.reasoning_content

content = response.choices[0].message.content

# Round 2

messages.append({'role': 'assistant', 'content': content})

messages.append({'role': 'user', 'content': "How many Rs are there in the word 'strawberry'?"})

response = client.chat.completions.create(

model="deepseek-reasoner",

messages=messages

)

# ...課金体系はトークン単位の従量制で、$0.14 / 1M (cache hit)、$0.55 / million (cache miss)、出力トークンは $2.19 / 1M となっています。

以下のグラフは、OpenAIのo1シリーズ(o1-mini、o1-preview、o1)との料金を比較したものです。

キャッシュヒット時・ミス時の単価ともに数倍~十数倍ほどDeepSeek-R1のほうが安価であることがわかります。

料金や詳細な利用手順は 公式ドキュメント で確認できます。

また、オープンソース版のモデルも同時に公開され、GitHubリポジトリやHugging Faceでダウンロードが可能です。

軽量モデル「DeepSeek-R1-Distill」の公開

QwenやLlamaベースに蒸留を施した1.5B~70B規模の6種類のモデルを用意。

以下のベンチマークの通り、小規模モデルでも十分に高い性能を発揮することが分かります。

32Bのモデルは多くの分野でo1-miniを超える推論能力を発揮していることが分かります。

DeepSeek-R1の驚異的な性能

DeepSeekが公開したベンチマーク比較によると、DeepSeek-R1は大規模な数学・プログラミング・言語処理タスクで驚異的な成績を残しています。

数学分野(AIME 2024相当テスト)

従来モデルを大きく上回り、80%近い正答率を達成しています。プログラミング(Codeforces、LiveCodeBench)

一般的なコード生成に加え、複雑なアルゴリズム問題で高い正解率を記録。OpenAIのo1-mini以上の数値も叩き出しています。言語処理・知識推論(MMLU、GPQA等)

英語および中国語の各種タスクで好成績を示し、最大128Kトークンの長文コンテキストでも安定して推論可能だとしています。

加えて、複数回答を生成・比較して最適解を導く、いわゆる自己検証的な推論プロセスも強化されています。

現在、誰でも無料で利用できるウェブ版で「DeepThink」機能をONにして会話すると、モデルが内部で考察しているステップを可視化することもできます。

ウェブ版のDeepSeek-R1に対して以下のようなプロンプトを入力してみます。

ガラスのコップにビー玉を入れ、逆さまにしてテーブルに置きます。その後、コップを持ち上げて電子レンジに入れました。このとき、ビー玉はどこにありますか?

推論過程と出力が以下です。赤ラインの部分は現実世界の物理現象をイメージして推論できている点です。

DeepSeek-R1の安全性とライセンス評価

MITライセンスの適用

DeepSeek-R1は、コードとモデルの重みの両方にMITライセンスを採用しており、商用利用や二次配布、派生モデルの作成が自由に行えます。

利用規約に関してはこちらから確認してご利用ください:

DeepSeek Privacy Policy:

LM StudioでDeepSeek R1をローカル動作させてみる

ここから先は

Amazonギフトカード5,000円分が当たる