【OpenAI開発者向け発表会まとめ】音声会話APIが登場!ファインチューニングも強化

待ちに待ったイベントが今年もやってきました。

本日(日本時間 10月2日)未明に行なわれた、OpenAIの開発者向け発表会。

今回の発表会は、これまでと異なり、3日間にわたってサンフランシスコ(今日)、ロンドン(現地時間10月30日)、シンガポール(現地時間11月21日)の3地点で開催される形式となっています。

また、昨年のようなライブストリーミングは行われていません。

そのため、公式がXに投稿した内容や参加者の投稿を元に、主要な発表が行われるキーノートの内容をまとめました。内容を把握したい方は、ぜひチェックしてみてください!

発表されたポイントは内容は大きく4つです。

リアルタイムAPI

プロンプトキャッシュ

モデル蒸留

画像対応のファインチューニング

それぞれ解説していきます。

Realtime API: 低遅延な音声対話を実現

Realtime APIのパブリックベータ版が登場。

この新APIにより、実質的に、ChatGPTアプリで利用可能な「高度な音声モード」をアプリに組み込むことが可能になります。

デモでは、音声入力に基づいてリアルタイムでマップを更新し、サンフランシスコを案内するAIツアーガイドが披露されました。

AIアシスタントが代わりに電話をかけ、食べ物をオーダーするデモ。

Realtime APIを使用している「Speak」という言語学習アプリ。

Realtime APIの特徴

音声入力と出力を直接ストリーミングし、より自然な会話体験を実現

GPT-4oモデルを使用し、単一のAPI呼び出しで音声対話を処理

WebSocket接続を通じて、リアルタイムでメッセージをやり取り

関数呼び出しに対応

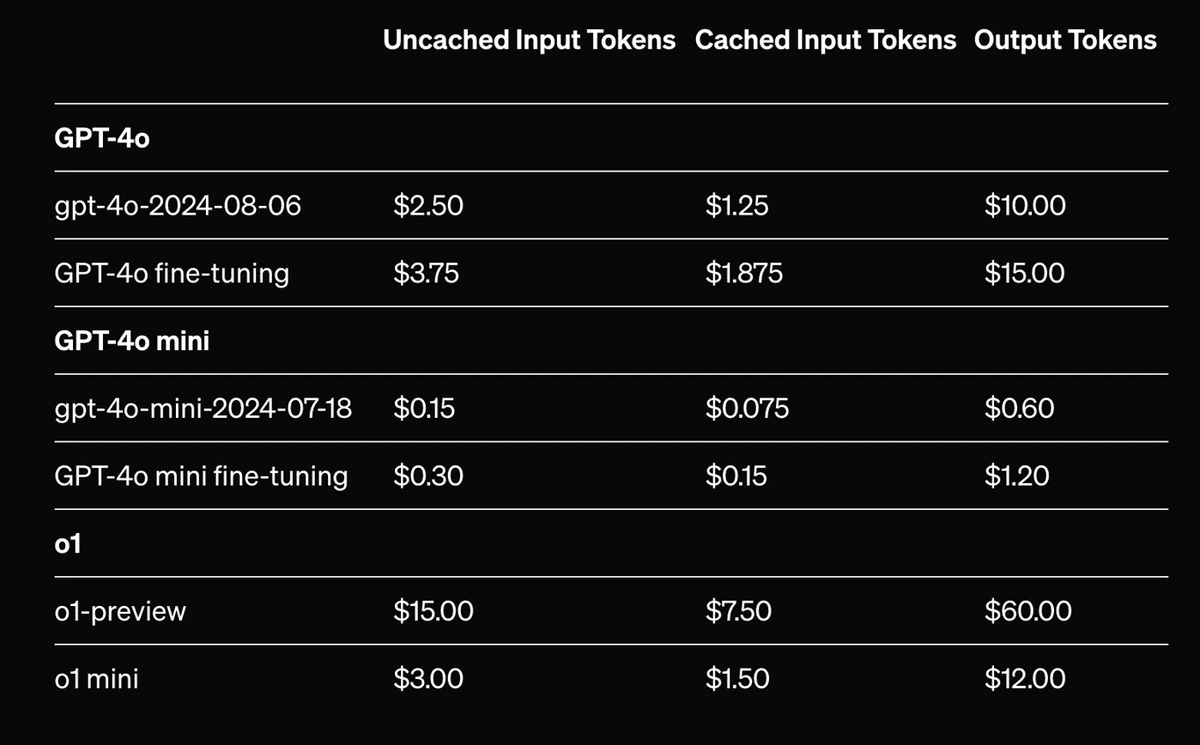

利用可能性と価格設定

有料開発者向けに本日からパブリックベータ版の提供が開始されます。

価格に関して、テキストトークンと音声トークンの両方を使用し、それぞれ異なる価格設定が適用されます:

テキスト入力:$5/1Mトークン、テキスト出力:$20/1Mトークン

音声入力:$100/1Mトークン、音声出力:$200/1Mトークン

今後の展開

今後、視覚や動画などのモダリティの追加、同時セッション数の増加、

SDKサポートの強化などの機能拡張を計画しています。

このRealtime APIにより、教育、特に語学系、翻訳、カスタマーサービス、アクセシビリティなど、幅広い用途での活用が期待されます。

GPT-4oファインチューニングの画像対応

次に、GPT-4oモデルに対する画像認識機能の強化を可能にする

Vision Fine-tuningが登場しました。

この新機能により、テキストだけでなく画像データも用いて

モデルをカスタマイズできるようになります。

Vision Fine-tuningの主な特徴

画像とテキストの両方を使用してGPT-4oをカスタマイズ可能

わずか100枚の画像でも性能向上

より大量のデータを使用することで、さらなる性能向上が期待

実際の活用例

実際の活用例として、フードデリバリーを運営する「Grab」が紹介されています。同社は道路標識の検出と車線数のカウントを改善し、マッピングデータの精度を向上させたとのこと。

また、自動化ソリューションを提供する「Automat」という企業は、UIの特定や文書からの情報抽出の成功率を大幅に向上させています。

安全性とプライバシー

エンタープライズ向けのプライバシー保護を適用しています。

ファインチューニングされたモデルは開発者の完全な管理下にあります。

利用可能性と価格設定

全開発者が現在、OpenAI Playgroundから利用可能です。2024年10月31日まで、1日100万トークンまで無料で提供されます。

その後、トレーニングは25ドル/1Mトークン、

推論は入力3.75ドル/1Mトークン、出力15ドル/1Mトークンの費用がかかってきます。

画像入力はサイズに基づいてトークン化され、

テキスト入力と同じ料金で課金されます。

Model Distillation:大規模モデルの出力で小規模モデルのファインチューニングが可能に

Model Distillationという発表されました。

この機能により、高性能な大規模モデル(GPT-4oやo1-preview)の出力を利用して、より効率的な小型モデルを蒸留させることが可能になります。

Model Distillationの主な特徴

Stored Completions: APIを通じて生成された入出力ペアを自動的に保存します。

Evals (ベータ版): カスタム評価をプラットフォーム上で作成・実行できます。

Fine-tuning: 既存の機能と完全に統合され、効率的なワークフローを実現します。

利用方法と利点

OpenAI Playgroundから利用可能です。

GPT-4oなどの大規模モデルの出力を使って、GPT-4o miniなどの

小規模モデルの性能を向上させることができます。開発者は単一のプラットフォーム内で、データセット生成から

モデルの微調整、性能評価まで一貫して行えます。特定のタスクに特化したコスト効率の高いモデルを作成できます。

利用可能性と価格設定

全ての開発者が利用可能で、GPT-4oやo1-previewを含む

全てのOpenAIモデルに対して使用できます。Stored Completionsは無料で提供されます。

Evalsはベータ版で、標準的なモデル価格で課金されます。

ただし、OpenAIとの共有に同意すれば年内は無料(週7回まで)です。Fine-tuningの価格は標準的な料金と同じです。

この新機能により、開発者はより効率的かつ高性能なAIモデルを

作成できるようになり、幅広いアプリケーションでの

AIの活用が促進されることが期待されます。

Prompt Caching: 効率的なAI処理を実現

Prompt Cachingが導入されました。

この機能により、繰り返し使用される入力トークンを再利用することで、

コストを削減し、処理速度を向上させることが可能になります。

Prompt Cachingの主な特徴

最近処理した入力トークンを再利用し、50%のコスト削減を実現します。

処理速度が向上し、レイテンシーが低減されます。

1,024トークン以上の長さのプロンプトに自動的に適用されます。

キャッシュは128トークン単位で増加します。

利用可能性と価格設定

GPT-4o、GPT-4o mini、o1-preview、o1-miniの最新バージョンで利用可能です。

これらのモデルのファインチューニングバージョンでも使用できます。

キャッシュされたプロンプトは通常より割引価格で提供されます。

キャッシュ使用状況のモニタリング

API応答の'usage'フィールド内に'cached_tokens'値が含まれます。

これにより、キャッシュされたトークン数を確認できます。

キャッシュの管理

5〜10分の非アクティブ状態で通常クリアされます。

最後の使用から1時間以内に必ず削除されます。

組織間でキャッシュは共有されません。

この新機能により、アプリケーションのパフォーマンス、

コスト、レイテンシーのバランスを取りながら、

効率的にAIアプリケーションを運用できるようになります。

その他

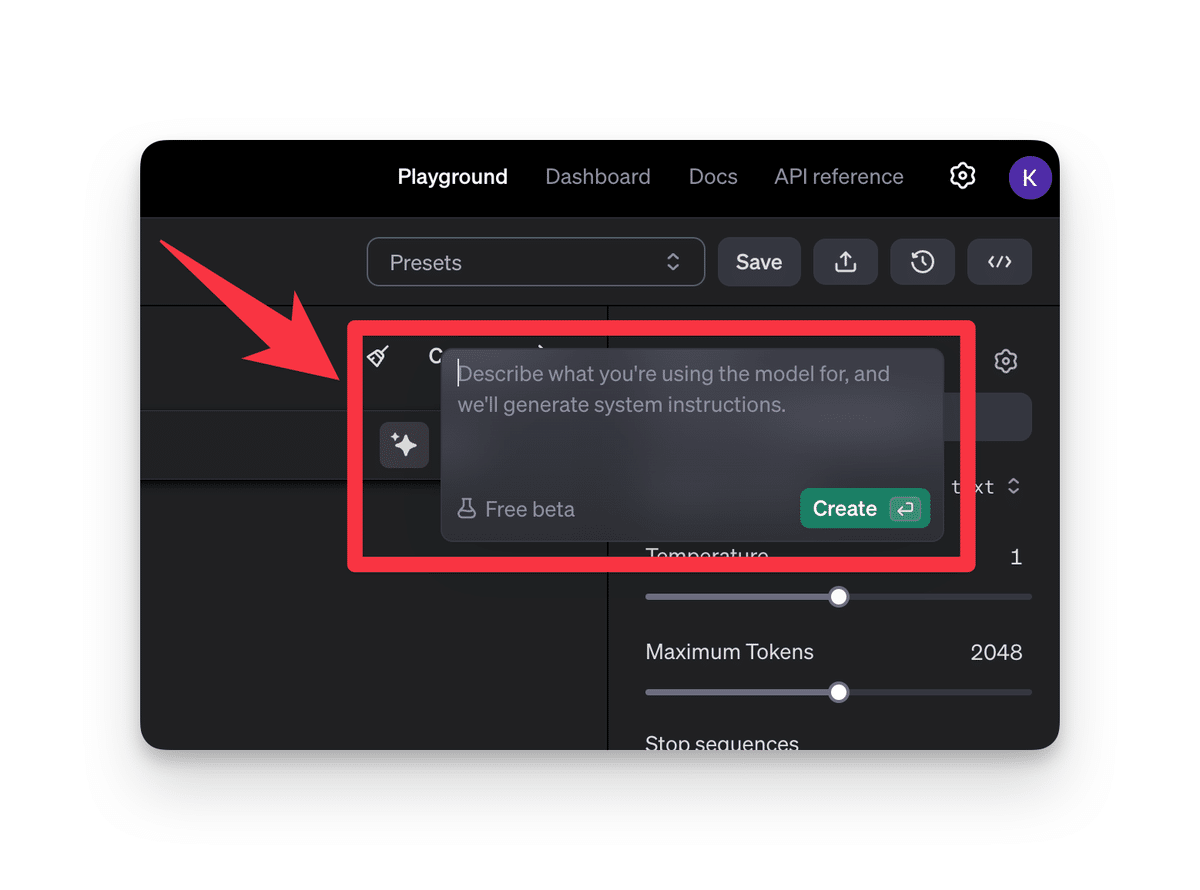

新Playground機能

OpenAI Playgroundにシステムプロンプトを自動生成する新機能が追加されました。

モデルの使用目的を記述するだけで、自動的にプロンプトを生成してくれます。

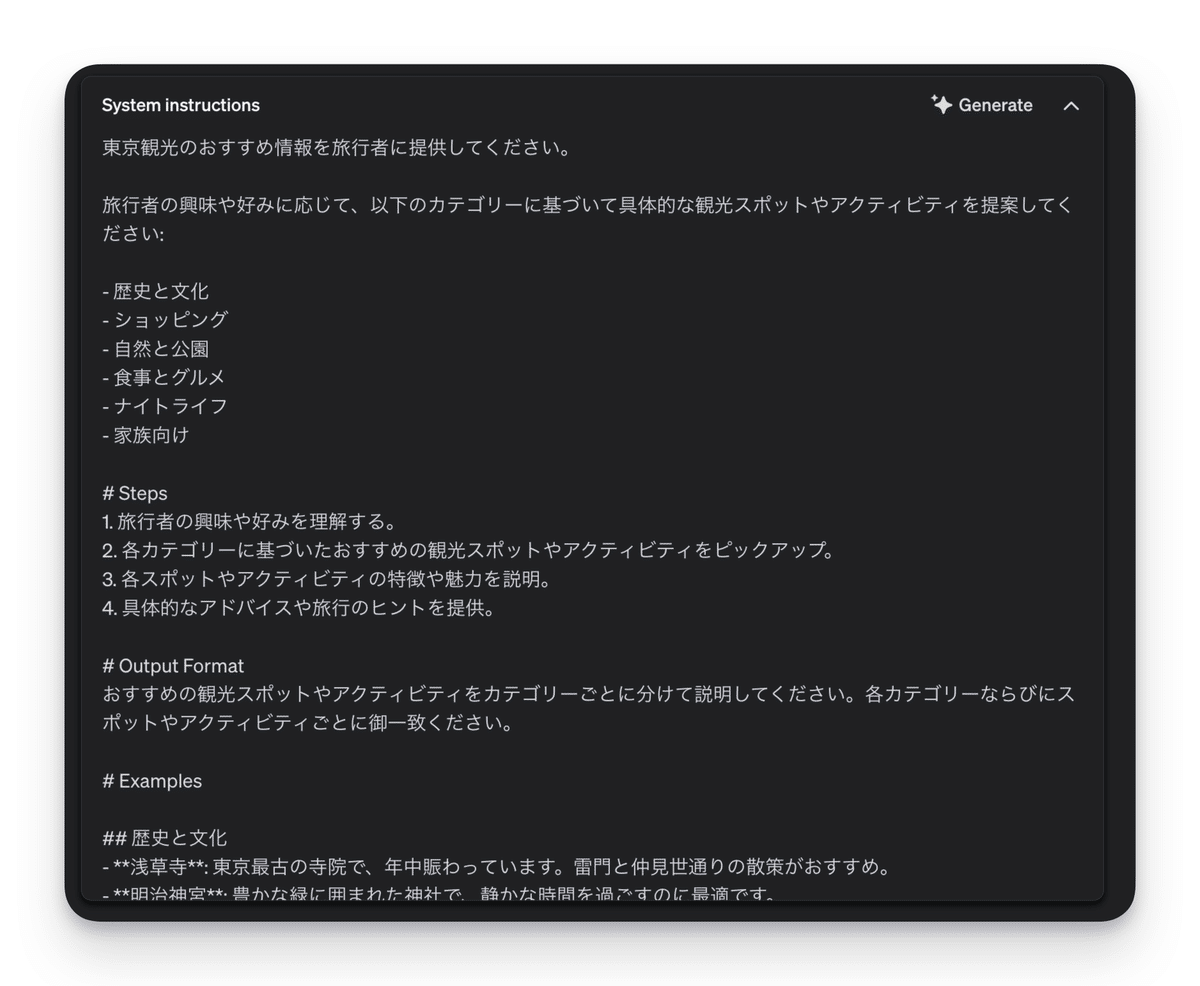

東京観光のおすすめ情報を提供する旅行アドバイザー

以下のように構造化されたシステムインストラクションが作成されます。

全文:

東京観光のおすすめ情報を旅行者に提供してください。

旅行者の興味や好みに応じて、以下のカテゴリーに基づいて具体的な観光スポットやアクティビティを提案してください:

- 歴史と文化

- ショッピング

- 自然と公園

- 食事とグルメ

- ナイトライフ

- 家族向け

# Steps

1. 旅行者の興味や好みを理解する。

2. 各カテゴリーに基づいたおすすめの観光スポットやアクティビティをピックアップ。

3. 各スポットやアクティビティの特徴や魅力を説明。

4. 具体的なアドバイスや旅行のヒントを提供。

# Output Format

おすすめの観光スポットやアクティビティをカテゴリーごとに分けて説明してください。各カテゴリーならびにスポットやアクティビティごとに御一致ください。

# Examples

## 歴史と文化

- **浅草寺**: 東京最古の寺院で、年中賑わっています。雷門と仲見世通りの散策がおすすめ。

- **明治神宮**: 豊かな緑に囲まれた神社で、静かな時間を過ごすのに最適です。

## ショッピング

- **銀座**: 高級ブランド店からユニークな工芸品店まで、ショッピング天国です。銀座の街を散策すること自体が楽しめます。

- **原宿竹下通り**: 若者文化の発信地で、ファッションアイテムや雑貨が豊富です。独特な雰囲気を楽しむことができます。

## 食事とグルメ

- **築地市場**: 新鮮な海鮮を楽しめる場所。特に早朝の市場見学と寿司朝食が人気です。

- **恵比寿エリア**: 洗練されたレストランが集まるエリアで、多様な料理を楽しめる。

(カテゴリの他の例やスポットは、旅行者の興味や季節に応じて追加してください)

# Notes

- 季節に応じた観光スポットのおすすめ(例えば、春には桜が見られる場所、秋には紅葉が楽しめる場所など)。

- 訪問者の年齢層や旅行スタイル(例: ファミリー旅行、カップル旅行、一人旅)に応じたカスタマイズ。

上記は簡易的な例ですが、関数や構造化された出力に対する有効なスキーマの生成もしてくれるようです。

ChatGPT研究所10万人突破記念キャンペーン

ChatGPT研究所のXフォロワー数が10万人を突破いたしました。

日頃のご支援への感謝を込めて、特別キャンペーンを実施いたします。

キャンペーン概要

期間:2024年10月1日から10月31日まで

内容:有料コミュニティ『AGIラボ』の初月無料体験

対象:期間中に新規でAGIラボにご参加いただく方全員

AGIラボの特徴

豊富なコンテンツ:AI強者を目指す方向けの質の高い記事を300以上提供

充実したマガジン配信:AI技術の最新動向を定期的にお届け

限定コミュニティ:Discordを通じた情報交換の場

既存会員様向け特別イベント

11月2日から4日にかけて、生成AI合宿を開催予定です。

「AIアプリを一個作りきろう」をテーマに、講義や実装タイムを予定しています。

AIの最新情報と深い知見を得られる『AGIラボ』に、

この機会に以下からぜひご参加ください。

キャンペーンの詳細や参加方法については、以下の記事をご覧ください。

質疑応答まとめ:対話形式

OpenAI DevDay SFにおいて、Sam AltmanとチーフプロダクトオフィサーのKevin Weilによる質疑応答セッションが行われました。

ここからは、そのセッションの主要なポイントをまとめています。

内容は、イベントをリアルタイムで中継してくださった方の記事を元に構成しています。

ここからはAGIラボ会員限定のコンテンツです

AGIラボとは?

AGIラボは最新のAI活用情報が集まるマガジン・コミュニティです。

会員特典

ChatGPT研究所が執筆した300以上ののAI関連記事が読み放題

AIに関する情報交換や議論ができる限定コミュニティへアクセス

【10月限定キャンペーン実施中】

さらに、今ならXフォロワー10万人突破を記念して、

10月中は初月無料でご参加いただけます。

興味のある方は、以下のリンクからぜひご参加ください: