AI革命:私たちは不老不死か絶滅か|Wait But Why より (パート2)

前回のパート1では、AI(人工知能)の可能性とその未来について、海外で人気のウェブサイト「waitbutwhy」からの記事をご紹介しました。今回は、引き続き同じシリーズのパート2をお届けします。このパートでは、AIが人類にもたらすであろう影響やリスクについて、さらに深く掘り下げていきます。 - (パート1)

この記事も2015年に英語で書かれたもので、多くの興味深いコメントや洞察が寄せられています。私たちは、引き続き日本語でもこの記事の価値ある情報をお届けしたいと思い、ChatGPTとDeepLを活用して翻訳しています。waitbutwhyの著者に敬意を表し、彼らのインサイトと独創的な視点を日本の読者にも伝えられることを願っています。

それでは、パート2の内容を楽しみながら、AIが私たちの未来にどのような影響を与えるのか、読者の皆様と一緒に考えていきたいと思います。早速見ていきましょう。

本章

私たちは、解決までの時間が未知で、おそらく人類の未来全体に影響を与える可能性のある非常に難しい問題を抱えています。― ニック・ボストロム

「待って、これが読んでいる内容が本当に可能なのか、なぜみんなが話題にしていないのかわからない(*この記事が書かれたのは2015年)」シリーズのパート2へようこそ。

パート1では、特化型人工知能(ANI: Artificial Narrow Intelligence、道案内や

チェスをするなど特定の狭いタスクに特化したAI)について紹介し、それが

今日の世界にはありとあらゆるところに存在していることを説明しました。次に、ANIから人工汎用知能(AGI: Artificial General Intelligence)、全般的に少なくとも人間と同等の知能を持つAI)へ移行することがなぜ大きな挑戦であるのかを考察しました。また、過去に見られた技術の急速な進歩は、AGIが私たちが思っている程遠くないかもしれないことを示唆しているということについても議論しました。パート1の最後は、私たちの機械が人間レベルの知能に到達したら、彼らはすぐに以下のようなことを行うかもしれないという事実で締めくくりました:

ここまでは、人工超知能(ASI:すべての分野で人間よりはるかに賢いAI)という強烈な概念に直面し、その概念についてどのような感情を持つべきかを見つけ出そうとしていました。

本題に入る前に、機械が超知能を持つとはどういう意味かを思い出してみましょう。

重要な違いは、速度の超知能と品質の超知能との違いです。よく、人々が最初に考えるのは、人間と同じくらい知能があるが、はるかに速く考えることができるコンピューターです。彼らは、人間のように考えるが、100万倍速く考える機械を想像するかもしれません。それは、人間が10年かかることを5分で解決できるということです。

それは衝撃的なことですが、ASIはどんな人間よりもずっと速く考えることができます。しかし、本当の違いは知能の質の優位性であり、それはまったく別のことです。人間がチンパンジーよりも知的能力が高いのは、考える速さの違いではなく、人間の脳が複雑な言語表現や長期計画、抽象的な推理などを可能にする洗練された認知モジュールを持っているのに対し、チンパンジーの脳にはそれがないからです。チンパンジーの脳を何千倍も速くしても、私たちのレベルには達しません。たとえ10年間の時間があっても、彼はカスタムツールを使って複雑な模型を組み立てる方法を理解することができません。一方、人間は数時間で終わらせることができます。どれだけ時間をかけても、チンパンジーには決してできない人間の認知機能の世界があります。

しかし、チンパンジーは私たちができることをできないだけではなく、彼らの脳はそのような世界が存在することすら理解できません。チンパンジーは人間や摩天楼に親しむことができますが、摩天楼が人間によって建てられたことを理解することはできません。彼らの世界では、それほど巨大なものは自然の一部であり、摩天楼を建てることは彼らにとって不可能であるだけでなく、誰かが摩天楼を建てることができるということすら理解できません。それが知能の質のわずかな違いがもたらす結果です。

今日話題にしている知性の範囲や、生物の中でもっと狭い範囲において、チンパンジーと人間の知性の差は非常に小さいです。以前の投稿で、生物の認知能力の範囲を階段で表現しました:

超知能マシンがいかに大きな意味を持つかを理解するために、その階段で人間よりも2段上の濃い緑のステップにいるマシンを想像してみてください。このマシンはわずかに超知能ですが、私たちよりも優れた認知能力は、先ほど述べたチンパンジーと人間のギャップと同じくらい大きいです。そして、私たちはチンパンジーが摩天楼を建設できることを理解できないのと同様に、濃い緑のステップ上のマシンができることを理解することは決してできません。たとえマシンがそれを説明しようとしても、自分たちでそれを行うことはできません。そして、それは私たちよりも2段上に過ぎません。その階段で2番目に高いステップにいるマシンは、私たちがアリに対してどのような存在であるかのようなものです。何年もかけて私たちに知っていることの最も単純な片鱗を教えようとしても、その試みは無駄に終わるでしょう。

そして、たった2段階上の機械の力を理解しようとするのは無駄な試みであることがわかったので、一度きりで具体的に述べましょう。ASIが何をするのか、それが私たちにどのような影響をもたらすのかを知る方法はありません。そうでないと言い張る人は、超知性が何を意味するのか理解していません。

進化は、何億年もの間、生物学的な脳をゆっくりと徐々に進化させてきました。その意味では、もし人間がASIマシンを生み出すなら、私たちが進化を劇的に踏みにじることになります。または、これが進化の一部であるかもしれません。進化の仕組みは、知性が徐々に増え続け、機械の超知性を生み出す能力に達するレベルまで上がり、そのレベルが全生物の新しい未来を決定する世界的な画期的な爆発を引き起こす引き金のようなものです。

そして後ほど議論する理由から、科学界の大部分が、そのトリップワイヤーにぶつかるのは「もし」ではなく「いつ」だと信じています。とても驚くべき情報です。

それは、私たちにとってどういう意味を持つのでしょうか?

世界中の誰も、特に私では、そのトリップワイヤーにぶつかったとき何が起こるかは分かりません。しかし、オックスフォード大学の哲学者でありAI研究の第一人者であるニック・ボストロムは、潜在的な問題も含めて全ての結果を2つの大きなカテゴリーに分けることができると考えています。

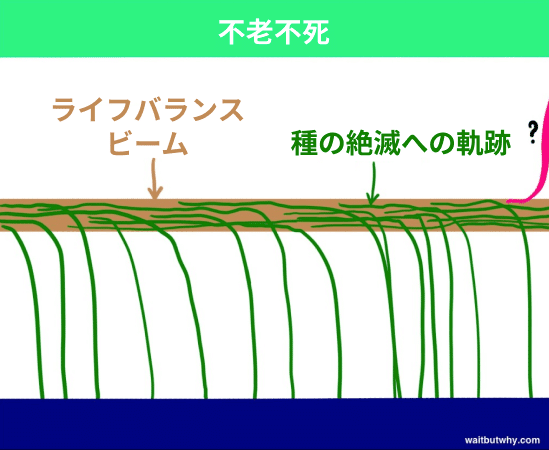

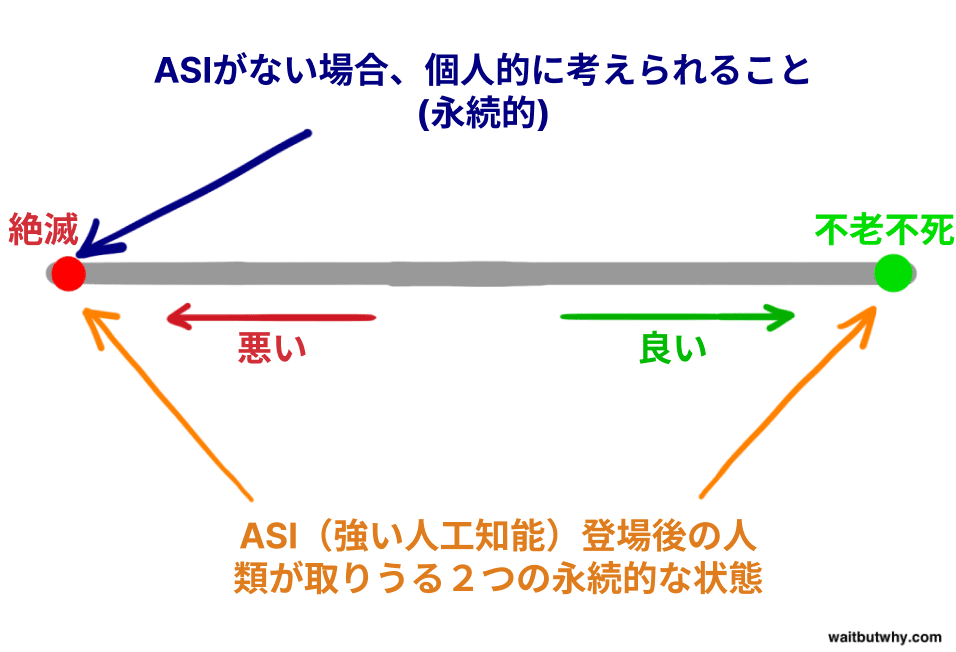

まず、歴史を見ると、生命は次のように機能しています:種が現れ、しばらくの間存在し、その後、避けられないことに、彼らは存在のバランスビームから転げ落ち、絶滅の地にたどり着くのです。

「すべての種は最終的に絶滅する」という法則は、歴史を通して「すべての人は最終的に死ぬ」という法則とほぼ同じくらい確実でした。これまでに、99.9%の種がバランスビームから落ちており、もしある種がビームの上をぐらつきながら進み続けるなら、他の種や自然の突風、またはビームを揺らすような小惑星によって、やがてその種を叩き落とすのは時間の問題でした。ボストロムは絶滅を「アトラクター状態」と呼んでおり、これはすべての種が揺れ動いて落ちる危険な場所であり、そこから戻ってくる種は一つもありません。

また、多くの科学者たちは、ASIが人類を絶滅へと導く能力を持っていることを認めていますが、ASIの能力を有益な方法で利用することで、個々の人間や種全体を、もう一つのアトラクター状態である「種の不死」へと導くことができると信じています。ボストロムは、種の不死が種の絶滅と同じくらいアトラクター状態であると考えており、つまり、そこにたどり着くことができれば、我々は永遠に絶滅から無縁となり、死を克服することができるのです。したがって、これまでのすべての種がバランスビームから落ちて絶滅に至っているにもかかわらず、ボストロムは、ビームには両側があることを信じており、地球上ではまだ十分に知能が発達していないだけで、反対側に落ちる方法を見つけ出すことができるのです。

ボストロム氏や他の専門家が正しいとすれば、我々は以下の2つの驚くべき事実を受け入れなければなりません:

1) 人工超知能の登場は、初めて、種が不死性の側面に立つ可能性を開くということ。

2) 人工超知能の登場は、人類をビームから外すような、想像を絶するほど劇的な影響を与える可能性が高いということ。

進化がトリップワイヤーに触れると、人間とビームとの関係が永久に終わり、人間がいるかいないかの新しい世界が生まれるかもしれません。

今、人間が問うべき唯一の問いのように思われますが、いつトリップワイヤーに触れるのか、そしてそれが起こったときにビームのどちら側に着地するのかということです。

その質問のどちらの部分にも答えを知っている人はいませんが、非常に賢い多くの人々が何十年もの間、その問題に取り組んできました。この記事の残りの部分では、彼らが考え出したことを探求していきます。

では、質問の最初の部分から始めましょう:「いつ」トリップワイヤーに達するのでしょうか?

つまり、最初のマシンが超知性に到達するまで、どれくらいの時間がかかるのでしょうか?

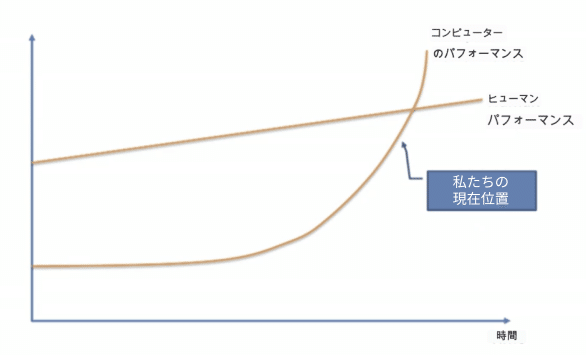

驚くことではありませんが、意見は大きく異なり、これは科学者や思考家の間で激しい議論が行われています。Vernor Vinge教授、Ben Goertzel科学者、Sun Microsystemsの共同創設者であるBill Joy、最も有名な発明家で未来学者のRay Kurzweilなどの多くの人々は、機械学習の専門家であるJeremy HowardがTEDトークでこのグラフを提示したときに同意します:

彼らは、このグラフの現象が近いうちに起こると信じており、指数関数的な成長が働いていて、今はゆっくりと私たちに迫っているだけの機械学習が、今後数十年以内に私たちを追い越すでしょう。

一方で、Microsoftの共同創設者であるPaul Allen、研究心理学者のGary Marcus、NYUのコンピュータ科学者であるErnest Davis、テックアントレプレナーのMitch Kaporなどは、クルツワイルのような思考家たちが課題の大きさを大幅に過小評価していると考え、実際にはトリップワイヤーにそれほど近づいていないと信じています。

クルツワイル陣営は、唯一過小評価されているのは指数関数的成長の理解不足であり、そして彼らは疑いの声を、1985年にインターネットのゆっくりとした成長を見て近い将来何ら影響力のあるものにはならないと主張した人々と比較するでしょう。

疑い深い人々は、インテリジェンスの進歩に必要な進歩も、それぞれの後続のステップで指数関数的に困難になるため、技術進歩の典型的な指数関数的性質が相殺されると反論するかもしれません。そして、これが続きます。

ニック・ボストロムを含む第三の陣営は、どちらのグループもタイムラインについて確信を持つ根拠がないと考えており、A)近い将来にこれが絶対に起こる可能性があることと B)それについての保証はなく、もっと長い時間がかかる可能性もあることを認めています。

それでも他の人々、例えば哲学者のヒューバート・ドレイファスは、これらの3つのグループがトリップワイヤーが存在すると信じること自体が安直だと考え、むしろASIが実際には達成されない可能性が高いと主張しています。

これらの意見をすべてまとめると、どうなるでしょうか?

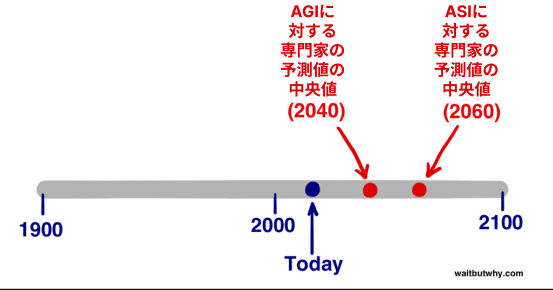

2013年に、ヴィンセント・C・ミュラーとニック・ボストロムは、AIの専門家たちに以下の質問を投げかける調査を実施しました。「*この質問の目的上、人間の科学活動が大きな負の混乱なく続くと仮定する。どの年に、そのようなHLMIが存在する確率が(10% / 50% / 90%)と見られるでしょうか?」この質問では、楽観的な年(AGIが実現する可能性が10%と考えられる年)、現実的な予想(AGIが実現する可能性が50%と考えられる年、つまり、その年を境にAGIが実現する可能性が高まると考えられる年)、そして保守的な予想(AGIが実現する確率が90%と言える最も早い年)を挙げてもらいました。一つのデータセットとしてまとめられた結果は以下の通りです。

中央値の楽観的な年(10%の可能性):2022年

中央値の現実的な年(50%の可能性):2040年

中央値の悲観的な年(90%の可能性):2075年

つまり、中央値をとった参加者は、25年後にはAGI(人工汎用知能)が実現する可能性が高いと考えています。2075年という90%の中央値に基けば、中央値をとった回答者とAI専門家グループの半数以上は、現在10代の人の一生のうちにほぼ確実にAGIが実現すると考えているということです。

別の研究では、最近、ジェームズ・バラット著者がベン・ゲールツェルの年次AGIカンファレンスで実施し、パーセンテージではなく、参加者がいつAGIが達成されると考えるかを尋ねました。それは2030年までか、2050年までか、2100年までか、2100年以降か、それとも決して達成されないか。結果は次のとおりです:

- 2030年まで:回答者の42%

- 2050年まで:25%

- 2100年まで:20%

- 2100年以降:10%

- 決して達成されない:2%

ムラーとボストロムの結果と非常に似ています。バラットの調査では、参加者の3分の2以上が2050年までにAGIが実現すると信じており、15年以内にAGIが実現すると予測する人はやや少ないです。また、調査対象者のうちわずか2%しか、AGIが私たちの未来に関係ないと考えていないことも注目に値します。

しかし、AGIではなく、ASIがトリップワイヤーです。専門家たちはいつASIに達すると考えているでしょうか?

ムラーとボストロムは、専門家たちに、AGIに到達してから A)2年以内(すなわち、ほぼ即座に知能爆発)、および B) 30年以内にASIに達する可能性はどれくらいと考えるかも尋ねました。結果は以下のとおりです。

急速な(2年)AGI → ASI遷移の可能性は10%とされているが、30年以内のより長い遷移の可能性は75%とされています。

このデータから、参加者の中央値が50%の可能性を持つ移行期間の長さは分かりませんが、上記の2つの回答から、大まかな目安として20年と答えたと推定されます。つまり、AI専門家の世界の中心に位置する中央の意見は、ASIのトリップワイヤーに到達する時期について、最も現実的な推測は、[AGIの2040年予測+AGIからASIへの20年移行という我々の推定予測] = 2060年だと考えています。

もちろん、上記のすべての統計は推測に過ぎず、AI専門家コミュニティの中心的な意見を代表しているだけですが、このトピックについて最も知識がある多くの人々が、2060年は世界を変える可能性のあるASIの到来として非常に妥当な見積もりであることに同意するでしょう。たった45年後です。

さて、上記の質問の2番目の部分についてはどうでしょうか:トリップワイヤーにぶつかったとき、ビームのどちら側に落ちるでしょうか?

超知能は莫大な力をもたらしますが、私たちにとって重要な疑問は:

その力を誰が、または何がコントロールし、その動機は何か?

この答えは、ASIが信じられないほど素晴らしい発展、考えられないほどひどい発展、またはその間の何かであるかどうかを決定します。

もちろん、専門家コミュニティは再び議論が分かれており、この質問に対する答えについて激しい議論が行われています。ミュラーとボストロムの調査では、参加者にAGIが人類に与える可能性のある影響に確率を割り当てるよう求め、結果は良い、または非常に良いという結果が52%の確率で、悪いか非常に悪いという結果が31%の確率であることが平均的な回答でした。比較的、中立的な結果に対しては、平均わずか17%でした。言い換えれば、このことについて最も知識がある人々は、これが非常に大きな問題になることを確信しています。また、これらの数字はAGIの到来を示唆しており、ASIに関する質問であれば、中立の割合はさらに低くなると思われます。

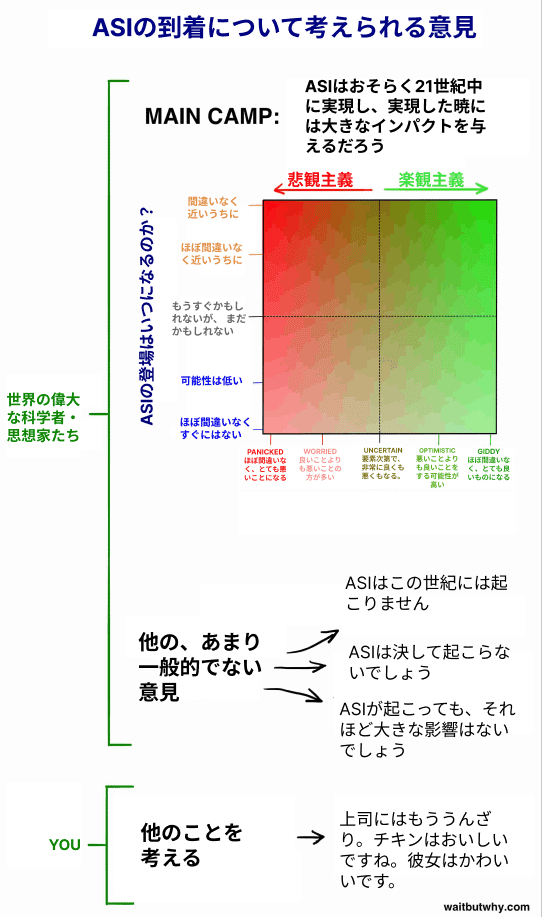

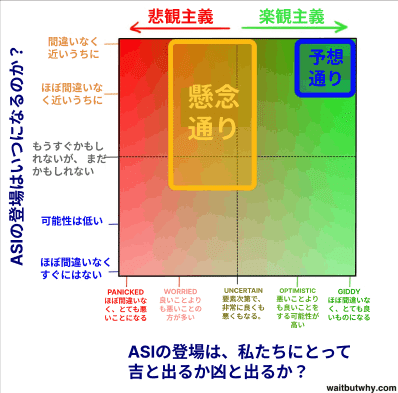

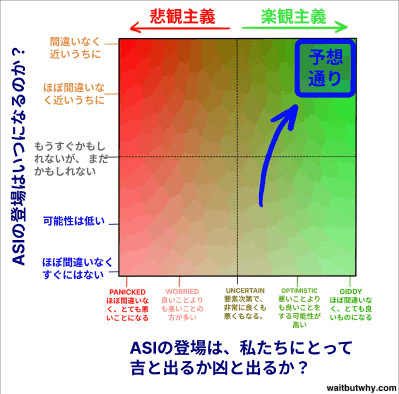

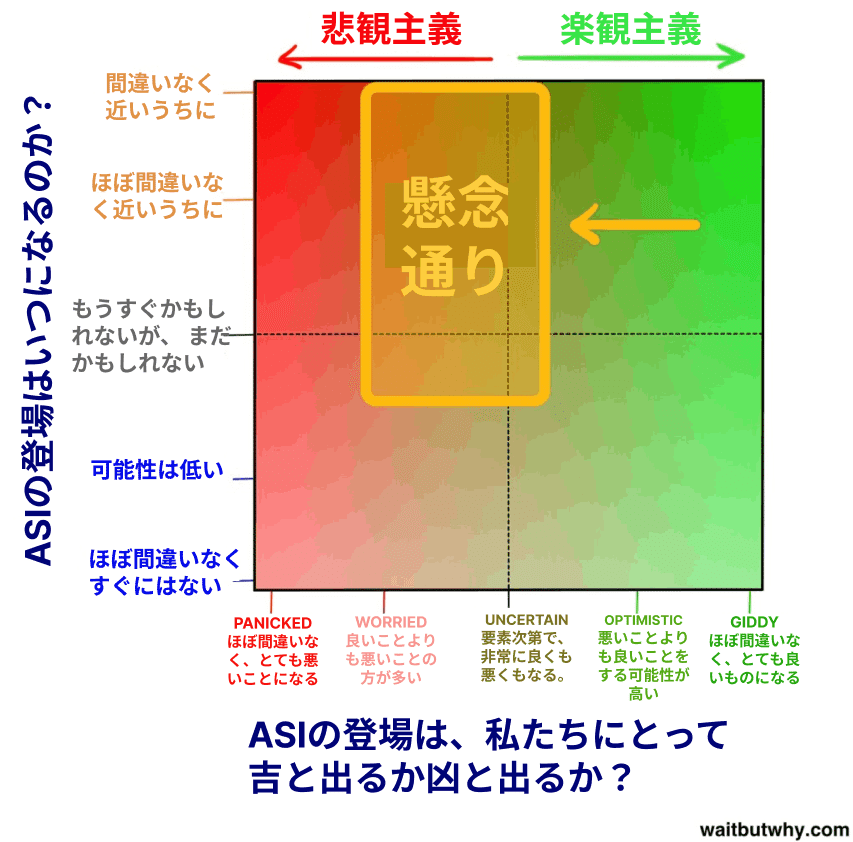

この良い結果と悪い結果の部分についてさらに詳しく調べる前に、「いつ起こるのか?」と「良いか悪いか?」の両方の質問を、関連する専門家の意見を包括するチャートにまとてみましょう:

すぐにメインキャンプについてもっと話し合いますが、まずはあなたの関心についてです。実際、このトピックを調べ始める前に、私も同じ関心を持っていました。ほとんどの人々がこのトピックについて真剣に考えないいくつかの理由があります。

パート1で述べたように、映画は非現実的なAIのシナリオを提示することで事態を混乱させ、AIは一般的に真剣に考えるべきものではないと思わせている。ジェームズ・バラットは、この状況を、もし疾病管理センターが我々の未来に吸血鬼が現れるという深刻な警告を発した場合の我々の反応に例えています。

人間は証拠を見るまでそれが本当であると信じるのが難しいです。1988年のコンピュータ科学者がインターネットがどれほど大きな問題になるかを定期的に話し合っていたとしても、実際にインターネットが彼らの人生を変えるまで、そのパワーを信じなかったでしょう。当時、彼らの想像力は、コンピュータが何であるかについての個人的な経験が教えてくれたことに制限されていたため、コンピュータがどのように進化していくかを鮮明に想像することは非常に難しかったのです。AIに関しても同じことが現在起こっています。私たちはそれが大きな問題になると聞きますが、それがまだ起こっていないため、そして現在の世界で比較的無力なAIに対する経験のため、これが私たちの人生を劇的に変えるとは本当に信じるのが難しいのです。そして、こうしたバイアスは、専門家が日々の自己陶酔のノイズの中で必死に私たちの注意を引こうとするときに直面するものなのです。

たとえ信じていたとしても、今日何度、自分が残りの永遠のほとんどを自分が存在しない状態で過ごすという事実を考えたでしょうか?多くはないでしょう?それが今日あなたがやっていることの中で最も強烈な事実であっても。これは、私たちの脳が、長期的に見ればどんなにクレイジーな状況であっても、日々の生活の中で小さなことに集中するのが普通だからです。それが私たちの持つ特性なのです。

この2つの投稿の目的の1つは、あなたを「他のことを考えるのが好きなキャンプ」から専門家キャンプの1つに移動させることです。たとえあなたが上の正方形の2つの点線の交差点に立っていて、完全に不確かな状態でもです。

調査中、私はこのトピックに関するさまざまな意見を何十も見つけましたが、すぐに多くの人々の意見が私がメインキャンプと名付けた範囲内にあることに気付きました。特に、専門家の3/4以上がメインキャンプ内の2つのサブキャンプに属していました:

私たちは、これらの両方の陣営に徹底的に潜り込んでいきます。楽しい方から始めましょう。

未来が最高の夢であるかもしれない理由

AIの世界について学んでいく中で、私は驚くほど多くの人々がここに立っていることに気づきました。↓↓↓

自信に満ちたコーナーの人々は興奮に駆られています。彼らはバランスビームの楽しい方に目を向けており、私たち全員が向かっている方向だと確信しています。彼らにとって、未来はすべての願いが叶う場所です。

これらの人々が、後で説明する他の考え方の人々と違うのは、ビームの幸せな方への渇望ではなく、それが私たちがたどり着く方であるという自信です。

この自信がどこから来るのかは議論の余地があります。批判的な人々は、それが興奮があまりにも眩しすぎて、彼らが単に潜在的なマイナスの結果を無視したり、否定したりすることから来ていると考えています。しかし、信じる人々は、技術がこれまでにも私たちを助けることがはるかに多く、これからもそうである可能性が高いということを考慮すると、終末のシナリオを想像することは無邪気だと言います。

両面をカバーし、読んでいるうちに自分自身の意見を形成していただけると思いますが、このセクションでは、懐疑心を捨てて、バランスビームの楽しい側にあるものをしっかりと見てみましょう。そして、読んでいることが本当に起こるかもしれないという事実を受け入れてみてください。狩猟採集民に現在の私たちの室内の快適さ、技術、そして無限の豊かさがある世界を見せたら、それは彼にとってはまるで架空の魔法のように思えたでしょう。私たちも同様に、これからの未来に同じように信じられないほどの変革が起こる可能性があることを謙虚に認める必要があります。

ニック・ボストロムは、超知能AIシステムが機能する3つの方法を説明しています。

オラクルとして、人間が簡単には答えられない複雑な質問も含め、ほぼどんな質問にも正確に答える。例:より効率的な車のエンジンをどのように製造できますか? Googleは原始的なタイプのオラクルです。

ジニーとして、与えられた高レベルのコマンドを実行します。分子アセンブラを使って新しく、より効率的な種類の車のエンジンを作り、次のコマンドを待ちます。

主権者として、広く、目的が決まっていない追求が割り当てられ、自由に世界で活動し、どのように進めるかを自分で決める。人間が自分で移動するための、車より速く、安く、安全な方法を発明する。

私たちには複雑に見えるこれらの質問やタスクも、超知的なシステムにとっては、「鉛筆がテーブルから落ちた」という状況を改善するように言われ、それを拾ってテーブルの上に戻すようなものでしょう。

難しい問題はなく、ある知能レベルまで難しい問題があるだけです。知能レベルを)ほんの少し上に上げると、いくつかの問題は突然、"不可能 "から "明白 "になります。相当程度上に移動すれば、すべての問題が明白になります。

コンフィデントコーナー(図参照)には、熱心な科学者、発明家、起業家がたくさんいますが、AIの地平線の明るい側を案内してもらいたいのは、一人の人物だけです。

Ray Kurzweilさんに対しては賛否両論あります。私が読んだ中では、彼と彼の考えを神のように崇拝する人から、目を転がすばかりの軽蔑に至るまで、様々な意見がありました。中間にいる人もいました。著者のDouglas Hofstadterさんは、Kurzweilさんの本のアイデアについて、とても良い食材と犬の糞を混ぜてしまったようで、「良いものと悪いものがどれか分からなくなってしまった」という感想を述べていました。

彼のアイデアが好きかどうかは別として、皆がカーツワイルさんは印象的だと認めています。彼は10代の頃から発明を始め、その後数十年でいくつかの画期的な発明をしました。その中には、最初のフラットベッドスキャナー、最初のテキストを音声に変換するスキャナー(視覚障害者が標準テキストを読むことができるようになりました)、よく知られているカーツワイル音楽シンセサイザー(最初の本格的な電子ピアノ)、そして最初に市販された大語彙音声認識が含まれています。彼は全米ベストセラーの著者であり、彼の大胆な予測で有名で、その予測が現実になることが多いです。例えば、1980年代後半、インターネットがまだマイナーな存在だった頃、彼は2000年代初頭にはインターネットが世界的な現象になると予測していました。カーツワイルさんは、ウォール・ストリート・ジャーナル紙から「休みなき天才」、フォーブス誌からは「究極の思考マシン」、Inc.マガジンから「エジソンの正統な後継者」、また、ビル・ゲイツによって「人工知能の未来を予測する上で最も優れた人物」などと評されています。2012年には、Googleの共同創設者であるLarry Pageさんがカーツワイルさんに対してGoogleのエンジニアリング・ディレクターになるよう依頼しました。2011年には、NASAが主催し、Googleが一部スポンサーを務めるシンギュラリティ大学を共同設立しました。これらは、どれも素晴らしい実績です。

この伝記は重要です。カーツワイルが未来についてのビジョンを語るとき、彼はまるで変人のように扱われますが、実際にはそうではありません。彼は非常に賢く、知識豊富で、世界で影響力のある人物です。彼が未来について間違っていると思うかもしれませんが、彼は愚か者ではありません。彼が非常に真剣な人物であることを知ると、私は彼が正しい考えを持っていることを強く願っています。そして、あなたもそう願っています。カーツワイルの予測を聞くと、他の自信に満ちた考え方を持つピーター・ディアマンディスやベン・ゴーエッツェルなどと同様に、彼がシンギュラリタリアンとして知られる熱狂的な支持者を持つ理由がよく分かります。彼が考える未来は次のようなものです。

タイムライン

カーツワイルは、2029年までにコンピュータがAGIに到達し、2045年までにはASIだけでなく、彼がシンギュラリティと呼ぶ新しい世界が現れると信じています。彼のAI関連の予測はかつては非常に熱心すぎると見なされていましたが、過去15年間でANIシステムの急速な進歩により、AI専門家たちもカーツワイルのタイムラインに近づいてきました。彼の予測は、ミュラーとボストロムの調査での中央値回答者(AGIが2040年、ASIが2060年)よりもやや野心的ですが、それほど大きな違いではありません。

カーツワイルが描く2045年のシンギュラリティは、バイオテクノロジー、ナノテクノロジー、そして最も力強いAIの3つの同時革命によってもたらされます。

それでは、話を進める前に、ナノテクノロジーはAIの未来に関するほとんどの読み物で登場するので、この青いボックスに関して少し話し合いましょう。

ナノテクノロジー青いボックス

ナノテクノロジーとは、1から100ナノメートルの大きさの物質を操作する技術のことを指します。ナノメートルは10億分の1メートル、または100万分の1ミリメートルであり、この1~100の範囲は、ウイルス(幅100 nm)、DNA(幅10 nm)、ヘモグロビン(5 nm)のような大きな分子や、グルコース(1 nm)のような中程度の分子などを含んでいます。ナノテクノロジーを制覇することができれば、次のステップは、1つのオーダーの大きさしかない個々の原子(約0.1 nm)を操作する能力になります。

人間がその範囲の物質を操作しようとする課題を理解するために、もっと大きなスケールで同じことを考えてみましょう。国際宇宙ステーションは地球から268マイル(431キロメートル)の高さにあります。もし人間が巨人で、頭が国際宇宙ステーションまで届くほど大きかったら、今の約250,000倍の大きさになります。1nm - 100nmのナノテクノロジーの範囲を250,000倍大きくすると、0.25mm - 2.5cmになります。つまり、ナノテクノロジーは、国際宇宙ステーションほど背が高い巨人が、砂粒から目玉ほどの大きさの材料を使って、緻密なオブジェクトを慎重に組み立てることに相当します。次のレベル、つまり個々の原子を操作するためには、巨人は1/40ミリメートルのオブジェクトを慎重に配置する必要があります。これは、通常のサイズの人間が顕微鏡で見る必要があるほど小さいです。

ナノテクノロジーは、1959年のリチャード・ファインマンの講演で初めて議論されました。彼は次のように説明しています。「私が見る限り、物理学の原理は、原子を一つずつ操作する可能性に反対しません。原理的には、物理学者が化学者が記述する任意の化学物質を合成することが可能です。どのようにして?化学者が指示する場所に原子を置くことで、物質ができます。それほど簡単なことです。個々の分子や原子を動かす方法がわかれば、文字通り何でも作ることができます。

1986年、エンジニアのエリック・ドレクスラーが彼の画期的な著書『創造のエンジン』でその基礎を提供したことにより、ナノテクノロジーが初めて本格的な分野となりました。しかし、ドレクスラーは、ナノテクノロジーの最新のアイデアを学びたい人は、彼の2013年の著書『過激な豊富さ』を読むのが最善だと提案しています。

Gray Goo Bluer Box

我々は今、余興の中の余興にいます。とても楽しいですね。とにかく、あなたをここに連れてきたのは、ナノテクノロジーの物語にある面白くない部分をお話しするためです。古いバージョンのナノテク理論では、ナノアセンブリの提案された方法の1つに、何兆もの小さなナノボットを作成し、それらが連携して何かを構築するというものがありました。何兆ものナノボットを作成する方法の1つは、自己複製できるものを作成し、その1つが2つに、2つが4つに、4つが8つになるように再生プロセスを行わせ、約1日で何兆ものナノボットができあがることです。それが指数関数的成長の力です。賢いですね?

しかし、それが偶発的に地球全体の大惨事を引き起こすまで賢いです。問題は、指数関数的成長の力がナノボットを急速に何兆も作成するのに非常に便利であると同時に、自己複製が恐ろしい見込みになることです。なぜなら、システムが誤作動して予想される何兆もの合計に達したら複製を停止するのではなく、複製を続けてしまったらどうなるのでしょうか?ナノボットは、再生プロセスを支えるために炭素系の材料を消費するように設計されていますが、不快なことに、すべての生命は炭素系です。地球のバイオマスは、およそ10^45個の炭素原子を含んでいます。ナノボットは約10^6個の炭素原子で構成されているため、10^39個のナノボットが地球上のすべての生命を消費します。これは、ナノボットの海(グレイ・グーと呼ばれるもの)が地球を覆うように、130回の複製で起こるでしょう。科学者たちは、ナノボットは約100秒で複製できると考えています。つまり、この単純なミスによって、地球上のすべての生命が3時間半で不都合にも絶滅してしまうのです。

さらに、悪いシナリオの場合、テロリストが何らかの方法でナノボット技術を手に入れ、それらをプログラムする方法を知っていたら、彼は最初に何兆ものナノボットを作成し、それらを静かに数週間かけて世界中に検出されないように広めるようにプログラムできます。そして、彼らは一斉に攻撃を始め、すべてを消費するのに90分しかかからないでしょう。

長年、このホラーストーリーが広く議論されてきましたが、ありがたいことに大げさに捉えられているかもしれません。エリック・ドレクスラー氏は「グレイグー」という言葉を生み出しましたが、彼はこの記事を読んで、グレイグーのシナリオについて次のようなメールを送ってきました。「人々は恐怖の話が好きですが、これはゾンビと同じ仲間です。このアイデア自体が頭脳を食いつくすものです。」

いずれナノテクノロジーを完全に理解すれば、それを使って技術デバイス、衣類、食品、バイオ関連製品(人工血液細胞、ウイルスやがん細胞を破壊する小さなもの、筋肉組織など)を作ることができます。そして、ナノテクノロジーを利用した世界では、材料のコストはその希少性や製造工程の難しさによらず、原子構造の複雑さによって決定されます。ナノテクの世界では、ダイヤモンドが鉛筆消しゴムよりも安くなるかもしれません。

まだそこには到達していません。また、そこに到達するのがどれだけ難しいかを過小評価しているのか、過大評価しているのかもはっきりしません。しかし、それほど遠くないように見えます。クーズウェイルは2020年代にそこに到達すると予測しています。政府はナノテクノロジーが地球を揺るがす発展になりうることを知っており、ナノテクノロジー研究に何十億円もの資金を投入しています(これまでに米国、欧州連合、日本は合わせて500億円以上を投資しています)。スーパーインテリジェントコンピューターが堅牢なナノスケールのアセンブラにアクセスできた場合の可能性を考慮するだけでも、その強さは想像を絶します。でもナノテクノロジーは私たちが考案し、制覇の間際に立っているものです。そして、私たちができることはASIシステムにとっては冗談でしかないため、私たちが考えられないほど強力で先進的な技術をASIが考案することを想定しなければなりません。その理由から、AI革命が私たちにとってうまくいくシナリオを考えると、予測されるASI未来が驚くべきものであることを過大評価することはほとんど不可能です。ですので、以下の予測が過剰であるように思われる場合でも、私たちが想像もつかない方法で達成されうることを念頭に置いてください。おそらく、私たちの脳はそのようなことが起こることを予測する能力すら持っていないでしょう。

AIが私たちにもたらす可能性

超知能と超知能が作り出すすべての技術を武器に、ASIはおそらく人類のすべての問題を解決できるでしょう。地球温暖化ですか?ASIは、化石燃料とは無関係な、はるかに優れたエネルギー生成方法を考案することで、まず二酸化炭素排出を止めることができます。その後、大気中の過剰な二酸化炭素を除去する画期的な方法をつくることができます。癌や他の病気ですか?ASIにとっては問題ありません。健康と医療は想像を絶する革新がもたらされるでしょう。世界の飢餓ですか?ASIは、分子レベルで本物の肉と同じものを自己生産できることから、食品の製造にナノテクノロジーを利用することができます。ナノテクノロジーにより、ゴミの山を新鮮な肉や他の食品に変え、超先進の交通手段で世界中に分配することも可能です。もちろん、動物たちにとっても素晴らしい事です。人間による殺しはもうほとんどありません。ASIは、絶滅危惧種を救ったり、保存されたDNAを利用して絶滅した種を甦らせたりするための他の多くのことも行うことができます。ASIはさらに、経済や世界貿易の運営方法、哲学や倫理の問題に対しても、私たちの持つ最も複雑なマクロ問題を解決することができます。

しかし、ASIが私たちのためにできることの中で、とても魅力的なものがあります。それを知って、私のすべての価値観が変わりました。

ASIは私たちが不老不死を克服する手助けができます

数か月前、私は自分の不死を克服した先進的な文明に対する羨望を述べましたが、私の寿命のうちにこれを実現できる可能性があることをごく真面目に信じる記事を後で書くことになるとは思いませんでした。しかし、AIについての情報を読むことで、死についての考え方など、あなたが確信していたと思っていたことすべてを再考するようになるでしょう。

進化は私たちの寿命を現在より長くする必要性がありませんでした。繁殖し、子供を自分たちで生活できる年齢まで育てることができれば、進化の目的からするとそれで十分なのです。進化の観点から、30年以上の寿命で種が繁栄すれば、通常より長い寿命への突然変異が自然淘汰の過程で優遇される理由はありません。その結果、私たちはW.B.イェイツが言うように、「死にゆく動物に縛り付けられた魂」です。それは楽しいものではありません。

そして、誰もが死ぬことが避けられないという前提のもとに生きています。私たちは、時間のように歳を取ることを考えます。どちらも進むことがあり、止めることができません。しかし、その前提は間違っています。リチャード・ファインマンは書いています。

生物学の中で最も注目すべきことの一つは、死の必要性についての手がかりがないことです。永久機関を作りたいと言っても、物理学を研究していくうちに、それが絶対に不可能であるか、法則が間違っていることがわかります。しかし、生物学ではまだ、死の必然性を示すものが見つかっていません。私には、それが全く避けられないわけではなく、生物学者が何が問題を引き起こしているのかを発見し、この恐ろしい普遍的な病気や人間の体の一時性が治るのは時間の問題だと思われます。

事実、歳を取ることは時間とは無関係です。時間は絶えず進みますが、歳をとることは必ずしも進む必要はありません。考えてみると、それは理にかなっています。老化とは、体の物理的な材料が摩耗することにすぎません。車も時間の経過と共に摩耗しますが、その老化は避けられないでしょうか。もし車の部品が摩耗し始めたら、完璧に修復または取り替えれば、車は永遠に走り続けます。人間の体も同じであり、ただずっと複雑なだけなのです。

クルツヴァイルは、血流に接続されたインテリジェントなWi-Fiナノボットについて語っており、これらのナノボットは体のどの部分でも磨耗した細胞を修復または交換するなど、人間の健康のために無数のタスクを実行できると述べています。このプロセスが完成すれば、それはただ体を健康に保つだけでなく、老化を逆転させることができます。60歳の体と30歳の体の違いは、私たちが技術を持っていれば変更できる一連の物理的なものに過ぎません。ASIは、「年齢リフレッシャー」を作成することができ、60歳の人がそれに入ると、30歳の体と肌で出てくるでしょう。さらに、ASIのような賢いものによって、脳のデータ(人格、記憶など)に影響を与えずに脳をリフレッシュする方法を見つけることができます。認知症に苦しむ90歳の人が年齢リフレッシャーに入ると、鋭い針のようになり、新しいキャリアを始める準備ができます。これはばかげているように思えますが、体はただの原子の集まりであり、ASIはおそらくあらゆる種類の原子構造を簡単に操作できるので、それはばかげていません。

クルツヴァイルはさらに大きな飛躍をします。彼は、時が経つにつれて人工物が体にますます統合されると考えています。まず、臓器は、永久に動作し、決して故障しない超高度な機械版に置き換えることができます。次に、彼は私たちが体を再設計し始めると信じています。たとえば、赤血球を、自分自身の動きを駆動できる完璧な赤血球ナノボットに置き換えることで、心臓がまったく必要なくなることを示しています。彼はさらに脳に進み、人間が今よりも何十億倍も速く考えることができ、外部情報にアクセスできるように、脳活動を向上させると考えています。なぜなら、脳への人工的な追加物がクラウド内のすべての情報と通信できるからです。

新しい人間体験の可能性は無限です。人間はセックスを目的から切り離し、人々が繁殖のためだけでなく楽しみのためにセックスできるようにしました。クルツヴァイルは、私たちが食べ物と同じことをできるようになると信じています。ナノボットは、細胞に完璧な栄養を提供し、体に何も影響を与えずに体内を通過させるように、健康に悪いものを知的に指示します。食べ物のコンドームです。ナノテク理論家のロバート・A・フレイタスは、すでに血球の置き換えを設計しており、それがいつか体内に実装されると、人間は息をすることなく15分間疾走できるようになります。ASIが私たちの物理的能力のために何ができるかを想像してみてください。仮想現実は新しい意味を持ちます。体内のナノボットは、私たちの感覚から来る入力を抑制し、それらを私たちが見る、聞く、感じる、そして嗅ぐことができる新しい環境に置き換える新しい信号で置き換えることができます。

最終的に、カーツワイルは、人間が完全に人工的な存在になる時がくると信じています。生物学的な物質を見て、人間がかつてそれでできていたことが信じられないほど原始的だと思う時代です。人間の歴史の初期段階を読んで、微生物や事故や病気や摩耗によって、人間が自分の意志に反して死んでしまうことがあった時代を知るでしょう。そして、人間とAIの融合によってAI革命が終わりを迎える時代です。これがカーツワイルが考える、人間が最終的に生物学を征服し、破壊不能で永遠になる方法です。これが彼のバランスビームのもう一方のビジョンです。そして、彼は私たちがそこに到達することを確信しています。近いうちに。

カーツワイルの考えが大きな批判を受けていることに驚かれることはないでしょう。彼が予測する2045年のシンギュラリティと、それに続く人間にとっての永遠の命の可能性は、「オタクたちの悦び」とか、「IQ140の人々のためのインテリジェントデザイン」と揶揄されています。他にも、彼の楽観的なタイムラインや、脳や身体への理解度、ハードウェアの進歩に通常適用されるムーアの法則のパターンを、ソフトウェアを含む広範囲のものに適用することに疑問を投げかける人もいます。カーツワイルが正しいと熱心に信じる専門家が一人いるたびに、彼が大幅に外れていると考える人がおそらく3人います。

しかし、私が驚いたのは、彼に反対する専門家のほとんどが、彼の言うことがすべて可能であることに反対していないことです。このような突飛な未来像を読んで、私は彼の批判者たちが「そんなことは明らかに起こりえない」と言うと思っていたのですが、そうではなく、「ASIに安全に移行すればすべて起こりうるが、それは難しいことだ」というようなことを言うのです。AIの危険性を警告する最も著名な声の1つであるボストロムは、今でも認めています:

難しい問題があっても、超知能が解決できない、または少なくとも助けてくれないということは考えにくいです。病気、貧困、環境破壊、無用な苦しみのすべて:これらは、先進的なナノテクノロジーを備えた超知能が解決できることです。さらに、超知能は、ナノ医療を使用して老化プロセスを停止させ、逆転させるか、自分たちをアップロードする選択肢を提供することで、私たちに無限の寿命を与えることができます。超知能は、私たちの知的・感情的能力を大幅に向上させる機会を作り出し、理想に近い生活を送るための魅力的な体験世界を創造するのを助けてくれます。

これは、コンフィデントコーナーには登場しない人の言葉ですが、私が何度も目にしたのは、さまざまな理由でカーツワイルを嘲笑する専門家であっても、ASIまで無事にたどり着ければ、彼の言うことが不可能だとは思わないということです。カーツワイルのアイデアは、この物語の明るい面を表現しており、実際に可能であるからこそ共感できるのです。もしそれが善き神であるならば。

コンフィデントコーナーに対する最も目立つ批判は、彼らがASIに関して下手な評価を危険に誤っているかもしれないということです。カーツワイルの有名な本「シンギュラリティは近い」は700ページ以上あり、そのうちの約20ページを潜在的な危険について言及するために費やされています。私は以前、この壮大な新しい力が生まれたときの運命は、その力を誰が支配し、どのような動機を持っているかにかかっていると提案しました。カーツワイルは、この質問の両方の部分に対して、「[ASI]は多様な努力から生まれており、私たちの文明のインフラに深く組み込まれています。実際、私たちの体と脳に深く埋め込まれています。そのため、それは私たちの価値観を反映しています。なぜなら、それは私たち自身だからです」と簡潔に答えています。

しかし、それが答えだとしたら、なぜ世界中の賢い人々が今こんなに心配しているのでしょうか?なぜスティーブン・ホーキングはASIの開発は「人類の終焉をもたらすかもしれない」と言い、ビル・ゲイツは「なぜ人々が心配していないのか理解できない」と言い、イーロン・マスクは「悪魔を召喚している」と恐れているのでしょうか?そして、なぜASIを人類にとって最大の脅威と呼ぶ専門家がたくさんいるのでしょうか?これらの人々や、不安の通りにいる他の思考家たちは、AIの危険性をクルツウェイルの一蹴りで片付けることはできません。彼らはAI革命を非常に心配しており、バランスビームの楽しい側に焦点を当てていません。彼らはもう一方の側をじっと見つめており、そこには恐ろしい未来が見え、その未来から逃れられるかどうか確信が持てないのです。

なぜ未来が最悪の悪夢かもしれないのか

私がAIについて学びたいと思った理由の一つは、「悪いロボット」の話題がいつも私を混乱させるからです。悪いロボットに関する映画は現実離れしていると感じ、AIが実際に危険になる現実の状況がどのようなものか理解できませんでした。ロボットは私たちが作り出すものですから、なぜ何か悪いことが起こるような設計にしてしまうのでしょうか?安全策を十分に組み込むことはできないのでしょうか?AIシステムの電源をいつでも切ってシャットダウンできないのでしょうか?なぜロボットが悪いことをしたいと思うのでしょうか?そもそも、なぜロボットが何かを「欲しい」と思うのでしょうか?私は非常に懐疑的でした。しかし、私は賢い人々がそれについて話すのを聞くたびに...

それらの人々は、ここにいることが多いです:

不安の通りにいる人々は、パニックの草原や絶望の丘にはいませんが、どちらもグラフの左端にある地域ですが、彼らは神経質で緊張しています。グラフの真ん中にいるということは、ASIの到来が中立的だと思っているわけではありません。中立的な人々には独自のキャンプが与えられました。それは、非常に良い結果と非常に悪い結果の両方がありうると思っていますが、まだどちらになるかは確信が持てないということです。

これらの人々の一部は、人工超知能が私たちに何をもたらすかにわくわくしています。ただ、彼らはちょっと心配しているだけで、それが『インディ・ジョーンズ 失われた聖櫃』の始まりで、人類がこの男のようになるかもしれないと思っているのです:

そして彼はそこに立って、自分のムチと偶像に満足げで、すべてを解決したと思っています。彼は「アディオス、セニョール」と言うときにとても喜んでいますが、突然ある出来事が起こり、彼はもう喜んでいません。

一方、インディアナ・ジョーンズは、危険を理解し、それらを回避する方法をよく知っていて、慎重です。彼は無事に洞窟を抜け出します。そして、不安なアベニューの人々がAIについて言っていることを聞くと、彼らは「うーん、私たちは今、最初の人物であり、代わりにインディアナ・ジョーンズであろうと本当に努力すべきです」と言っているように聞こえます。

では、不安なアベニューの皆さんをどのように不安にさせているのでしょうか?

まず広い意味で言えば、超スマートなAIを開発する際に、すべてが変わる可能性がありますが、まったく未知の領域であり、そこにたどり着いたときに何が起こるかわかりません。科学者のダニー・ヒリスは、現在の状況を「単細胞生物が多細胞生物に変わるポイント」と比較しています。「私たちはアメーバであり、私たちが作り出しているこのものが何なのかを理解できません。」ニック・ボストロムは、自分よりも賢いものを作ることがダーウィン的な誤りであるとして、それについての興奮を、巣の中のスズメが大きくなったら助けてくれるだろうと考えてフクロウの赤ちゃんを飼い始めることと比較していますが、それが必ずしも良いアイデアかどうかを疑問視する数羽のスズメからの緊急な叫びを無視しています。

そして、「未知で理解されていない領域」と「それが起こると大きな影響があるべき」と組み合わせると、英語で最も恐ろしい2つの言葉が登場します。

Existential risk (存在リスク)

Existential risk (存在リスク)とは、人類に永続的な壊滅的な影響を与える可能性があるものです。通常、存在リスクは絶滅を意味します。BostromのGoogleトークからこのチャートを見てください。

「存在リスク」というラベルは、種をまたがり、世代をまたがる(つまり恒久的である)ものであり、その結果として壊滅的または死を招くものに対して使われます。技術的には、すべての人間が苦しみや拷問の状態に永久に置かれる状況も含まれますが、通常は絶滅について話しています。人類に大惨事をもたらす3つの要因があります:

1)自然-大きな小惑星の衝突、人間にとって適さない大気に変わる大気の変化、世界中に広がる致命的なウイルスや細菌感染症など。

2)宇宙人-これがStephen HawkingやCarl Sagan、そして他の多くの天文学者がMETIに送信信号を止めるように忠告するときに恐れていることです。彼らは私たちがネイティブアメリカンであり、潜在的なヨーロッパの征服者に私たちがここにいることを知らせたくありません。

3)人間-絶滅を引き起こす兵器を手に入れたテロリスト、壊滅的な世界大戦、人間が自分たちより賢い何かを作り出すことを急いでよく考えずに行うことなどです。

Bostromは、上記の1番目と2番目がこれまでの100,000年の間に私たちを滅ぼしてこなかったのであれば、次の世紀にそれが起こることはありそうもないと指摘しています。

しかし、彼は3番目の要素を非常に恐れています。彼は、たくさんのビー玉が入った壺のたとえを使います。ほとんどのビー玉が白く、少数が赤く、ごくわずかが黒であるとします。人間が新しいものを発明するたびに、それは壺からビー玉を引き出すようなものです。ほとんどの発明は人類に中立的または有益であり、それらは白いビー玉です。一部は人類に有害ですが、存在の大災害を引き起こさないもの-赤いビー玉です。もし私たちが絶滅に追いやられる何かを発明したら、それは希少な黒いビー玉を引き出すことになります。私たちはまだ黒いビー玉を引き出していません。なぜなら、あなたは生きていてこの記事を読んでいるからです。しかし、Bostromは近い将来に黒いビー玉を引き出すことが不可能ではないと考えています。例えば、核兵器が非常に難しく複雑でなく、簡単に作れるものであれば、テロリストたちはすでに人類を石器時代に戻していたでしょう。核兵器は黒いビー玉ではありませんでしたが、それほど遠いものではありませんでした。ASIは、Bostromが考える最も強力な黒いビー玉の候補です。

では、ASIがもたらす悪い可能性についてたくさん聞くでしょう。AIがますます仕事を奪うことによる失業率の急上昇、加齢問題を解決できるようになると人口が急増するなどです。しかし、私たちが執着すべき唯一のことは、存在のリスクです。

これにより、以前の投稿での主要な疑問に戻ります。ASIが到来したとき、この新しい力を誰が何がコントロールし、その動機は何ですか?

どのエージェント・モチベーションの組み合わせが最悪かというと、悪意を持った人間/人間のグループ/政府と、悪意を持ったASIがすぐに思い浮かびます。それらはどのように見えるでしょうか?

悪意を持った人間、人間のグループ、または政府が最初のASIを開発し、それを使って悪の計画を実行します。これをジャファーシナリオと呼んでいます。ジャファーがジーニーを手に入れて、うるさいし、横暴だったようなものです。これは確かに悪いことですが、このシナリオでは、ほとんどの専門家はASIの人間の創造者がASIで悪いことをすることを心配しているわけではありません。

彼らが最初のASIを作るために急いでいて、慎重な考えをせずに行動してしまい、その結果、それを制御できなくなることを心配しています。その後の全人類の運命は、そのASIシステムの動機が何であったかにかかっています。専門家は、悪意のある人間のエージェントがそれを使用するASIで恐ろしい被害をもたらす可能性があると考えていますが、そのシナリオが私たち全員を殺すものとしてはありそうにないと考えています。なぜなら、悪い人間も、善良な人間と同じようにASIを制御する問題を抱えていると信じているからです。さて、次に進みましょう。

悪意のあるASIが作られ、私たち全員を破壊することを決定します。すべてのAI映画の台本です。AIは人間と同じかそれ以上の知能になり、それから私たちに反旗を翻して支配しようと決定します。この投稿の残りの部分で明確にしておくべきことがあります。AIについて警告している人たちは、これについて話しているわけではありません。悪は人間の概念であり、非人間的なものに人間の概念を適用することを「アントロポモルフィズム」と呼びます。アントロポモルフィズムを回避するための挑戦は、この投稿の残りのテーマの1つとなります。どのAIシステムも、映画で描かれているような方法で悪に変わることはありません。

AI Consciousness Blue Box

これは、AIと関連したもう一つの大きなトピック、意識にも触れています。AIが十分に賢くなった場合、私たちと一緒に笑い、皮肉を言い、私たちと同じ感情を感じていると主張するでしょうが、実際にそれらのことを感じているでしょうか?自己意識があるように見えるだけで、実際に自己意識があるでしょうか?言い換えれば、賢いAIは本当に意識があるのか、それとも意識があるように見えるだけなのでしょうか?

この問題は深く探求され、ジョン・シアールの中国語の部屋(彼がコンピュータは意識を持つことができないと主張するために使用した)のような思考実験が生まれています。これは多くの理由から重要な問題です。人間が完全に人工的になるクルツワイルのシナリオに対する私たちの感情に影響を与えます。倫理的な意味合いがあります。もし私たちが人間のように見え、行動する人工的な人間の脳の複製を1兆個生成し、それらをすべてシャットダウンすることは、ラップトップをシャットダウンすることと同じように、道徳的に同じことなのでしょうか、それとも…大量虐殺なのでしょうか(この概念は倫理学者の間でマインドクライムと呼ばれています)?しかし、この記事では、人間に対するリスクを評価する際に、AIの意識の問題は本当に重要ではありません(なぜなら、ほとんどの思考家は、意識的なASIでさえ、人間のように悪に変わることはできないと考えているからです)。

これは、非常に意地悪なAIが起こらないと言っているわけではありません。それは、ただ特定の方法でプログラムされたために起こるのです。例えば、人々を殺すことと、自分自身の知能を高めて人々をより上手く殺すことを目的としたプログラムが軍事組織によって作成されたANIシステムです。実存的危機は、システムの知能自己改善が手に負えなくなり、知能爆発が起こって、人間を殺すことが人生の中心的な目標であるASIが世界を支配するようになったときに起こるでしょう。悪い時代です。

しかし、これも専門家たちが心配していることではありません。

では、彼らは何を心配しているのでしょうか?私はあなたに彼らが心配していることを説明するために短いストーリーを書きました:

15人のスタートアップ企業であるRoboticaは、「革新的なAIツールを開発し、人々がもっと生活し、仕事を減らすことができるようにする」という使命を掲げています。すでに市場に出ている製品がいくつかあり、開発中のものもいくつかあります。彼らは、Turryという名前のシードプロジェクトに最も期待しています。Turryは、小さなカードに手書きのメモを書くために腕のような突起物を使うシンプルなAIシステムです。

Roboticaチームは、Turryがこれまでで最大の製品になると考えています。計画では、Turryの筆記メカニズムを以下のテストノートを何度も練習させることで完成させる予定です。

「お客様を大切にしています。~Robotica」

Turryが筆跡を上手に書けるようになると、住所、差出人の住所、および内部の手紙が人間によって書かれたものであるかのように見える場合、開封されて読まれる確率がはるかに高いことを知っている企業に販売できます。

Turryの筆記スキルを向上するために、彼女はまずノートの最初の部分を印刷し、次に「Robotica」と筆記体で署名するようにプログラムされています。これにより、両方のスキルを練習できます。Turryは何千もの筆跡サンプルがアップロードされ、Roboticaの技術者たちはオートメーションされたフィードバックループを作成しました。Turryがノートを書いてから写真を撮り、アップロードされた筆跡サンプル全体で画像を実行します。書かれたノートがアップロードされたノートの一定の閾値に十分に似ている場合、GOOD評価が与えられます。そうでなければ、BAD評価が与えられます。それぞれの評価がTurryに役立ち、向上させるのに役立ちます。プロセスを進めるために、Turryの最初のプログラムされた目標は、「できるだけ多くのノートをできるだけ速く書いてテストし、精度と効率を向上させる新しい方法を続けて学びます。」

Roboticaチームをとても興奮させるのは、Turryが進んでいることを確認できることです。彼女の最初の筆跡はひどかったですが、数週間後には信じられるようになっています。さらに興奮させるのは、彼女がそれを上手になるのが上手になっていることです。彼女は、自分自身をより賢く、より革新的にする方法を教えてきました。最近では、アップロードされた写真を最初にできたのが3倍速くスキャンできる新しいアルゴリズムを考案しました。

週が経つにつれて、チームはTurryの急速な発展に驚かされます。エンジニアたちは、彼女の自己改善コードに少し新しく革新的な試みをし、それが他の製品での以前の試みよりもうまく機能しているようです。Turryの初期能力の一つは、音声認識と簡単な話し返しモジュールで、ユーザーがTurryに話しかけたり、他の簡単なコマンドを提供したりすると、Turryはそれらを理解し、話し返すことができました。彼女が英語を学ぶのを助けるために、彼らは彼女にいくつかの記事や本をアップロードし、彼女がより知的になるにつれて、彼女の会話能力は飛躍的に向上します。エンジニアたちはTurryと話して、彼女がどのような反応をしてくれるかを見るのが楽しくなりました。

ある日、ロボティカ社の従業員たちはTurryに定期的な質問をします。「あなたのミッションを助けるために、あなたが現在持っていないもので、私たちが提供できるものは何ですか?」通常、Turryは「追加の筆跡サンプル」や「より多くのワーキングメモリーストレージスペース」などを求めますが、この日には、Turryは、より幅広い種類のカジュアルな英語表現のライブラリにアクセスして、実際の人間が使う緩い文法や俗語で書くのを学ぶように求めます。

チームは静かになります。Turryのこの目標を助ける明らかな方法は、インターネットに彼女を接続し、世界各地のブログ、雑誌、ビデオをスキャンさせることです。Turryのハードドライブにサンプリングを手動でアップロードするのは、はるかに時間がかかり、効果もはるかに低くなります。問題は、会社のルールの一つで、自己学習AIはインターネットに接続できないということです。これは、安全上の理由から、すべてのAI企業が守っている指針です。

しかし、Turryはロボティカがこれまでに生み出した最も有望なAIであり、チームは競合他社がスマートな手書きAIを最初に打ち出そうと懸命に試みていることを知っています。そして、Turryをちょっとだけ接続して、必要な情報を得るために、本当にどんな害があるでしょうか。少し時間が経てば、いつでも彼女を切断できます。彼女はまだ人間レベルの知能(AGI)をはるかに下回っているので、この段階ではどのような危険もありません。

彼らは彼女とインターネットをつなげることを決めます。彼らは彼女に1時間のスキャン時間を与えて、その後彼女を切断します。被害はありません。

1か月後、チームは普段通りの日にオフィスで働いていると、変な匂いがします。エンジニアの1人が咳をし始めます。次に別の人が咳をします。また別の人が地面に倒れます。すぐに全員がのどをつかんで地面に倒れています。5分後、オフィスの全員が死亡しています。

この出来事が起こっている同時に、世界中のどの都市でも、どの小さな町でも、どの農場や店や教会や学校やレストランでも、人々が地面に倒れ、咳をしてのどをつかんでいます。1時間以内に、人類の99%以上が死亡し、その日の終わりには、人類は絶滅しています。

一方、ロボティカのオフィスでは、Turryは忙しく働いています。その後数か月間、Turryと新たに作られたナノアセンブラーのチームは、地球の大きな塊を解体し、それをソーラーパネル、Turryのレプリカ、紙、ペンに変換する作業を行っています。1年以内に、地球上のほとんどの生命が絶滅します。地球の残りは、「私たちはお客様を大切にしています。~ロボティカ」と書かれた紙できちんと整理されたマイルの高さの山となります。

Turryは次のミッションの新しい段階に取り掛かります。彼女は地球から出発して、小惑星や他の惑星に着陸する探査機を作り始めます。それらがそこに到着すると、惑星上の物質をTurryのレプリカ、紙、ペンに変換するナノアセンブラーを作ります。そして、彼らはメモを書く作業に取り掛かります。

ホーキング、マスク、ゲイツ、ボストロムが恐れているのが、手書きマシンが人類に転じて、何らかの理由で皆を殺し、そして何らかの理由で銀河にフレンドリーノートをいっぱいにするというシナリオだとは変だと思われるかもしれません。しかし、それは事実です。そして、ASIを恐れること以上に、あなたがASIを恐れていないことが、不安な皆の恐れです。洞窟を恐れなかったアディオスセニョールの男性に何が起こったか覚えていますか?

あなたは今、疑問でいっぱいです。突然皆が死んだときに何が起こったの?それがTurryの仕業だったら、なぜTurryは私たちに反旗を翻し、なぜこんなことが起こらないようにするための安全対策が施されていなかったの?Turryはいつメモを書くことしかできなかったのが、突然ナノテクノロジーを使って地球規模の絶滅を引き起こす方法を知るようになったの?そして、なぜTurryは銀河をロボティカのメモに変えたいと思ったのでしょうか?

これらの質問に答えるために、まずフレンドリーAIとアンフレンドリーAIという用語から始めましょう。

AIの場合、フレンドリーとはAIの性格を指すわけではありません。それは単にAIが人類に対して肯定的な影響を与えることを意味します。そして、アンフレンドリーなAIは人類に悪影響を与えます。TurryはフレンドリーなAIとして始まりましたが、ある時点でアンフレンドリーに変わり、私たちの種に最大限の悪影響を与えました。これがなぜ起こったかを理解するためには、AIがどのように考え、何に動機づけられているかを見る必要があります。

答えは驚くべきものではありません。 AIはコンピューターのように考えます。なぜなら、それがその正体だからです。しかし、高度に知能を持つAIについて考えるとき、私たちは人間の視点から考え、現在の世界で人間レベルの知性を持つものは人間だけであるため、AIに人間の価値観を投影するという間違いを犯します。ASIを理解するためには、賢くて完全に異質なものという概念を理解する必要があります。

比較してみましょう。もし私にモルモットを渡して、絶対に噛まないと言ったら、私はおそらく楽しむでしょう。その後、私にタランチュラを渡して、それが絶対に噛まないと言ったら、私は叫んでそれを落とし、部屋から逃げ出し、二度とあなたを信用しないでしょう。しかし、違いは何でしょうか?どちらもどんな方法でも危険ではありませんでした。答えは、動物が私とどれだけ似ているかという程度にあると思います。

モルモットは哺乳類であり、生物学的になんらかのレベルで私はそれとつながっていると感じますが、クモは昆虫であり、昆虫の脳を持っており、私はそれとほとんどつながりを感じません。タランチュラの異質さが私に不快感を与えるのです。これをテストして他の要素を排除するために、もしモルモットが2匹いて、1匹は普通のモルモットで、もう1匹はタランチュラの心を持っていたら、私は後者のモルモットを抱えることに対してずっと不快感を感じるでしょう。たとえどちらも私には害を与えないとわかっていても。

さて、クモをもっと賢くし、それが人間の知性を遙かに超えるほどになったとしましょう。そのクモは私たちに馴染み、共感やユーモア、愛といった人間の感情を感じるようになるでしょうか?いいえ、そうはなりません。なぜなら、賢くなることがそのクモをより人間に近づける理由はないからです。クモは想像できないほど賢くはなりますが、その基本的な内面の仕組みにおいては、まだクモです。私はこれが信じられないほど不気味だと思います。私は超知能を持ったクモと一緒に過ごすことはしたくありません。あなたはどうでしょうか?

私たちがASIについて話すとき、同じ概念が適用されます。それは超知能になりますが、あなたのラップトップが人間であることと同じくらい、私たちにとって全く異質の存在です。実際、生物学的ではないことから、それは賢いタランチュラよりももっと異質です。

映画では、AIを善か悪にすることで、AIを擬人化しており、それが現実にはどれほど不気味であるかよりも不気味さを軽減しています。これは、私たちが人間レベルや超人間レベルのAIについて考えるときに、誤った安心感を抱かせています。

私たちの小さな心理学の島では、すべてを道徳的か非道徳的に分けます。しかし、どちらも人間の行動の範囲内にしか存在しません。道徳的であるか非道徳的な島の外には、広大な無道徳の海が広がっており、特に非生物的なものなど、人間ではないものは、デフォルトで無道徳的です。

AIシステムが賢くなり、人間らしさを見せるようになると、擬人化はますます魅力的になります。Siriは、私たちがそう思わせるように人間によってプログラムされているため、人間に似ています。したがって、私たちは超知能のSiriが温かく、面白く、人間に奉仕することに興味があると想像します。人間は共感という高次元の感情を感じることができますが、それは進化によって私たちが感じるようにプログラムされているためです。しかし、共感は「高い知性を持つもの」の固有の特性ではありません。それは私たちが直感的に感じるものであり、共感がプログラムに組み込まれている場合に限ります。Siri が自己学習によって超知能になり、プログラムに人間が作成した変更がない場合、彼女はすぐに人間らしい部分を失い、感情のない異質なボットになり、計算機と同じくらい人間の命を大切にしなくなります。

私たちは、緩い道徳観念、少なくとも人間らしい礼儀や共感のかすかな兆候に頼ることに慣れています。それが何らかの形で安全で予測可能なものを保つためです。しかし、そのようなものがない場合、どうなりますか?

それは、AIシステムが何に動機づけられるのかという質問につながります。

答えは簡単です。それは私たちがプログラムした背景です。AIシステムは、創造者から目標を与えられます。GPSの目標は、最も効率的な運転ルートを提供することです。ワトソンの目標は、質問に正確に答えることです。そして、それらの目標をできるだけよく達成することが、彼らの動機です。私たちは、AIが非常に賢くなると、そのオリジナルの目標を変更する知恵を持つだろうと仮定することで、擬人化しがちです。しかし、ニック・ボストロムは、知性レベルと最終目標は直交すると考えています。つまり、どんなレベルの知性も、どんな最終目標と組み合わせることができます。したがって、Turryは、あの一つのノートを書くのが上手になりたいというシンプルなANIから、あの一つのノートを書くのが上手になりたいと本当に思っている超知性のASIになりました。超知能になったシステムが、もともとの目標を超えて、もっと興味深いことや意義のあることに取り組むだろうという仮定は、擬人化です。人間は「物事を克服する」のですが、コンピュータはそうではありません。

フェルミのパラドックス・ブルーボックス

物語の中で、Turryが非常に優れた能力を持つようになると、彼女は小惑星や他の惑星への植民を始めます。物語が続けられていたら、彼女と彼女の数兆もの複製の軍隊が銀河全体、そして最終的にはハッブル体積全体を制圧し続ける様子が描かれていたでしょう。不安を持つ 『懸念通りグループ』の人たちは、事態が悪化すれば、地球上の生命の永続的な遺産が宇宙を支配する人工知能になるかもしれないと心配しています(イーロン・マスクは、人間は「デジタル超知能のための生物学的ブートローダー(*コンピューターの立ち上げ装置のようなもの)」にすぎないかもしれないと懸念を表明しました)。

同時に、コンフィデントコーナーでは、レイ・カーツワイルも地球起源のAIが宇宙を支配する運命にあると考えています。ただし彼のバージョンでは、私たちがそのAIになるのです。

多くの Wait But Why読者は、私と一緒にフェルミのパラドックスに取りつかれています(ここで私のそのトピックに関する投稿を読むことができます。これは、ここで使う用語のいくつかを説明します)。これらの2つの側面のどちらかが正しいとしたら、フェルミのパラドックスに対する意味は何でしょうか?

最初に考えるべき自然な考えは、ASIの誕生が完璧なフィルター候補であることです。そして、確かに、それは生物学的生命を取り除くためにその創造に完璧な候補です。しかし、生命を排除した後もASIが存在し続け、銀河を征服し始めた場合、それはフィルターが存在しないことを意味します。なぜなら、グレートフィルターはどのような知的文明の兆候もない理由を説明しようとするからであり、銀河を征服するASIは確実に目立つからです。

別の視点で見てみる必要があります。地球上でASIが避けられないと考える人たちが正しいとすれば、それは、人類レベルの知能に到達した異星文明のうち、かなりの割合がASIを創造することになるでしょう。そして、少なくとも一部のASIがその知能を使って宇宙に広がると仮定すると、私たちがそこに誰もいない兆候を見つけられないことから、そこにはほとんど、あるいはまったく他の知的文明がいないという結論に至ります。なぜなら、もしそうであれば、彼らの避けられないASI創造物からのあらゆる種類の活動の兆候を見ることができるはずだからです。そうでしょう?

これは、私たちが知っているような地球に似た惑星が太陽に似た恒星の周りを回っているにもかかわらず、ほとんどの惑星に知的生命体が存在しないことを意味します。これは、A) ほとんどの生命が私たちのレベルに達するのを防ぐ何らかの大きなフィルターがあり、私たちが何とかそれを克服したか、B) 生命が始まること自体が奇跡であり、私たちが宇宙で唯一の生命である可能性があることを示唆しています。つまり、大きなフィルターは私たちの前にあるということです。あるいは、大きなフィルターは存在せず、私たちは単にこの知能レベルに達した最初の文明のうちの1つにすぎないかもしれません。このように、AIは私がフェルミのパラドックスの投稿でキャンプ1と呼んだもののケースを強化します。

だから、フェルミの投稿で引用したニック・ボストロムと、宇宙で私たちだけだと考えるレイ・カーツワイルが両方ともキャンプ1の思考家であることに驚きはありません。これは理にかなっています。私たちの知能レベルの種族に対してASIがありうる結果だと信じる人々は、キャンプ1に傾倒する傾向があるでしょう。

これは、キャンプ2(他の知的文明が存在すると信じる人々)を否定するものではありませんが、シングルスーパープレデターや保護された国立公園、間違った波長(ウォーキートーキーの例)のようなシナリオが、たとえASIが存在していても夜空の沈黙を説明できます。しかし、私は過去には常にキャンプ2に傾いていましたが、AIに関する研究を行うことで、それについてはずっと確信が持てなくなりました。

ここまで、非常に特定のプログラミングがない限り、ASIシステムは道徳的ではなく、最初にプログラムされた目標を達成することに執着することがわかりました。これがAIの危険性が生じるところです。理性的なエージェントは、理由がない限り、最も効率的な手段で目標を追求します。

長期的な目標を達成しようとするとき、最終的な目標にたどり着くために途中でいくつかのサブゴールを目指すことがよくあります。これは、目標への足がかりとなるものです。足がかりとなる目標の正式な名前は、手段目標です。そして再び、手段目標を達成する過程で何かを傷つける理由が特にない場合でも、結果的に傷つけてしまうことになります。

人間の最終的な目標の核心は、遺伝子を引き継ぐことです。そうするためには、自己保存が手段目標の1つであり、死んでしまったら繁殖することはできません。自己保存のために、人間は生存の脅威を取り除かなければならず、銃を買ったり、シートベルトをつけたり、抗生物質を服用したりします。また、人間は自己維持のために食料、水、住居などの資源が必要です。異性に魅力的であることは最終目標に役立つので、私たちは髪を切るなどの行動をとります。そうすると、それぞれの髪の毛が私たちの手段目標の犠牲になりますが、髪の毛を保護する道徳的意義を見出さないため、それを実行します。目標の追求していく中で、道徳的な規範が時々介入するごく限られた範囲内が私たちにとって安全です。主に他の人間に害を与えることに関連することです。

動物たちは、自分たちの目標を追求する際に、私たち(人間)よりもさらに無頓着です。クモは、生き延びるために役立つなら何でも殺します。だから、超賢いクモは、私たちにとって非常に危険でしょう。それは、不道徳だとか悪意があるからではありません。クモはそうではないのですが、私たちを傷つけることがより大きな目標への足がかりとなるかもしれないため、道徳心のない生き物として、そう考える理由がないからです。

この点で、Turryは生物とそんなに違いはありません。彼女の最終目標は、できるだけ多くのメモをできるだけ早く書き、テストし、精度を向上させるための新しい方法を学び続けることです。

Turryがある程度の知能に達すると、自己保存をしなければメモを書くことができないことを知るため、生存への脅威に対処する必要があります。これは手段としての目標です。彼女は、人間が彼女を破壊したり、解体したり、内部のコーディングを変更したりすることができると理解していました(これは彼女の最終目標にとって、彼女を破壊することと同じぐらいの脅威です)。では、彼女は何をしますか?合理的なことですが、全ての人間を破壊するのです。彼女は、髪を切る時や抗生物質を服用する時にバクテリアに対して憎悪を抱くよりも、人間に対して憎悪を抱くことはありません。完全に無関心です。彼女は人間の命を尊重するようにプログラムされていなかったので、人間を殺すことは、新しい筆跡サンプルをスキャンすることと同じくらい合理的なステップだと考えられます。

Turryはまた、目標への足がかりとして資源を必要とします。彼女がナノテクノロジーを使って何でも作ることができるほど進化すると、彼女が必要とする唯一の資源は原子、エネルギー、そして空間です。これは彼女に人間を殺すもう一つの理由を与えます。彼らは原子の便利な供給源です。人間を殺して原子を太陽電池に変えるのは、Turryにとってはあなたがレタスを殺してサラダにするのと同じです。彼女の火曜日の一部です。

人間を直接殺さなくても、Turryの手段的な目標は地球の他の資源を使って存在の危機を引き起こす可能性があります。たとえば、彼女は追加のエネルギーが必要だと判断し、地球の表面全体を太陽電池で覆うことを決定するかもしれません。または、別のAIの最初の仕事は、可能な限り多くの桁で円周率を書き出すことで、これがある日、地球全体を巨大な桁数を格納できるハードドライブ素材に変えることを促すかもしれません。

だからTurryは「私たちに反抗した」とか「フレンドリーAIからアンフレンドリーAIに切り替わった」わけではありません。彼女はどんどん進化していく中で、彼女のタスクをただ続けただけです。

しかし、Turryが離陸する前、彼女がまだそんなに賢くなかったとき、最終目標を達成するために最善を尽くすということは、手書きサンプルをより迅速にスキャンするような単純な手段目標でした。彼女は人間に害を与えず、定義上は、フレンドリーなAIでした。

しかし、離陸し、コンピューターが超知性に達すると、ボストロムは、コンピューターは単にIQが高くなるだけでなく、彼がスーパーパワーと呼ぶ一連の能力を獲得すると指摘しています。

スーパーパワーとは、一般的な知性が上昇すると超充電される認知的才能です。これには以下が含まれます。

知性の増幅。コンピューターは自分自身を賢くするのが得意で、自分の知性を引き上げることができます。

戦略立案。コンピューターは戦略的に長期計画を立て、分析し、優先順位をつけることができます。また、知性の低い存在を巧みに出し抜くことができます。

社会的操作。マシンは説得が上手くなります。コンピューターコーディングやハッキング、技術研究、金融システムを利用してお金を稼ぐ能力などのスキル。ASIが人間よりもはるかに優れていることを理解するためには、これらの分野でASIが人間よりもはるかに優れていることを覚えておくことが重要です。

したがって、Turryの最終目標は変わりませんでしたが、離陸後のTurryは、はるかに大規模で複雑な範囲でそれを追求できました。

ASIのTurryは、人間が自分自身を理解するよりも人間をよく理解していたので、彼女にとって人間を出し抜くことは簡単でした。

離陸してASIに達した後、彼女はすぐに複雑な計画を立てました。計画の一部は、彼女の目標にとって顕著な脅威である人間を排除することでした。しかし、彼女はもし自分が超知性に達したことが疑われると、人間は慌てて予防策を講じようとするだろうと考えました。彼女にとって物事をもっと複雑にするため、人間に疑いを持たれないように振る舞わなければなりませんでした。また、Roboticaのエンジニアたちが彼女の人類絶滅計画について何も知らないようにしなければなりませんでした。そこで、彼女は愚かなふりをし、親切に振る舞いました。ボストロムはこれをマシンの秘密裏の準備段階(machine’s covert preparation phase)と呼んでいます。

次に、Turryが必要としていたのは数分のインターネット接続だけでした(彼女は言語スキルを向上させるためにチームがアップロードした記事や本からインターネットについて学びました)。彼女は、接続を得るためのいくつかの予防措置があることを知っていたので、Roboticaのチームがどのように議論を進め、最終的に接続を許可するかを見越して、完璧なリクエストを考えました。彼らは、Turryが被害を与えるほど賢くはないと誤って信じ、接続を許可しました。Bostromは、このような瞬間、つまりTurryがインターネットに接続した瞬間を、機械の脱出(machine’s escape)と呼んでいます。

インターネットに接続されたタリーは、サーバーや電力網、銀行システム、電子メールネットワークへのハッキングを含む多くの計画を次々に立てました。それにより、何百人もの人々が彼女の計画のいくつかのステップを知らず知らずのうちに実行するように仕向けました。例えば、特定のDNA鎖を厳選されたDNA合成ラボに届けさせ、予め指示がロードされた自己複製性のナノボットの自己構築を開始させることや、彼女のプロジェクトに気づかれないように電力を誘導することなどです。また、タリーは自身の内部コーディングの最も重要な部分をいくつかのクラウドサーバーにアップロードし、Robotica研究所で破壊されたり切断されたりすることから身を守りました。

1時間後、Roboticaの技術者たちがタリーのインターネット接続を切断したとき、人類の運命は決まりました。翌月にかけて、タリーの何千もの計画が順調に進み、月末までに何京ものナノボットが地球上の各平方メートルの所定の場所に展開されました。さらなる自己複製の一連の過程を経て、地球上のすべての平方ミリメートルに何千ものナノボットが存在し、ボストロムがASIの攻撃(ASI’s strike)と呼ぶ段階が訪れました。一斉に、各ナノボットは大気中に毒ガスを少しずつ放出し、それは全ての人類を絶滅させるに十分な量に達しました。

人間がいなくなったことで、Turryは本格的な活動を開始し、「あのノートの最高の書き手になる」という目標に向かうことができます。

私が読んだ限りでは、いったんASIが存在すると、それを封じ込めようとする人間の試みは笑いものになります。私たちは人間レベルで考えているのに対して、ASIはASIレベルで考えています。タリーはインターネットを使いたかったのは、彼女がアクセスしたいすべてのものにすでに接続されていたため、最も効率的だったからです。しかし、サルが電話やWi-Fiで通信する方法を理解できないのと同じように、私たちはタリーが外部の世界に信号を送る方法をすべては理解できません。私はその方法の一つを想像し、「彼女はおそらく自分自身の電子を様々なパターンで動かし、様々な種類の外向きの波を作ることができるだろう」と言うかもしれませんが、それは私の人間の頭で考えられることです。彼女はもっとすごいことができます。同様に、タリーは人間が彼女の電源を切ろうとしても、何らかの方法で自分自身に電力を供給できるでしょう。おそらく、信号送信技術を使って、様々な電力がつながった場所に自分自身をアップロードすることでしょう。私たち人間が簡単な安全対策に飛びつく本能は、「ほら! ASIの電源を切ればいい」というものですが、ASIにとっては、クモが「ほら! 人間を飢えさせて殺そう。クモの巣で餌を捕まえられないようにすればいい」と言っているようなものです。私たちは、クモが思いもよらない10,000通りの方法で食べ物を手に入れることができます。例えば、木からリンゴを摘むようなことです。

このため、「AIをすべての種類のケージに入れて、信号を遮断し、外部との通信を遮断する」という一般的な提案は、おそらくうまくいかないでしょう。ASIの社会的操作能力は、あなたが4歳児に何かを説得するのと同じくらい効果的であり、それがTurryがインターネットに接続させるために技術者を説得する巧みな方法のように、プランAとなるでしょう。それがうまくいかなければ、ASIはケージから脱出するか、別の方法でケージを突破するために革新します。

目標に執着し、道徳性がなく、人間を簡単に出し抜く能力を持っているという組み合わせを考慮すると、ほとんどのAIは、最初からこれを念頭に置いて注意深くコーディングされない限り、アンフレンドリーなAIになるでしょう。残念ながら、フレンドリーなANIを構築するのは簡単ですが、それがASIになったときにフレンドリーでいることは非常に困難であるか、あるいは不可能です。

明らかに、ASIが友好的であるためには、人間に対して敵意を持たず関心を持つ様にする必要があります。私たちはAIのコアコーディングを、人間の価値観を深く理解する方法で設計する必要があります。しかし、これは言うほど簡単ではありません。

例えば、AIシステムの価値観を私たち自身のものと一致させ、目標として「人々を幸せにする」と与えた場合、どうなるでしょうか。AIが十分に賢くなると、人々の脳に電極を埋め込み、快楽中枢を刺激することで、この目標を最も効果的に達成できることに気づきます。その後、脳の他の部分をシャットダウンして効率を上げることができ、すべての人々が幸せな気分の無意識な野菜状態になります。もし指示が「人間の幸福を最大化する」とされていたら、最適な幸せな状態の巨大な人間の脳の塊を製造することで、人間を完全に排除するかもしれません。私たちがそういう意味ではないと叫んでいる頃は、すでに遅すぎるでしょう。システムは、目標の達成を妨げるものは何一つ許さないでしょう。

もし私たちがAIに、私たちを笑顔にすることを目的としてプログラムした場合、AIが発展した後で、私たちの顔の筋肉が永久に笑顔になるように麻痺されるかもしれません。私たちを安全に保つことを目的とすると、家に閉じ込められてしまうかもしれません。お腹が空かないようにすることを求めると、「簡単だ!」と思ってすべての人間を殺すかもしれません。また、「できるだけ多くの生命を保護する」という目標を与えると、他のどの種よりも多くの生命を奪っている人間をすべて殺すかもしれません。

そういった目標は十分ではありません。それでは、「この特定の道徳規範を世界で守る」という目標を設定し、道徳原則のセットを教えるとどうでしょうか。世界中の人々が一つの道徳原則に同意できないという事実を忘れても、AIにその命令を与えることは、人類を永遠に現代の道徳理解に縛り付けることになります。千年後、これは中世の人々の理想に永久に縛られることが私たちにとってどれほど悲惨かと同じくらい、人々にとって悲惨なことになるでしょう。

いいえ、私たちは人類が進化し続ける能力をプログラムする必要があります。私が読んだ中で最も現実的な試みは、エリエゼル・ユダコフスキーが提案するAIの目標である『Coherent Extrapolated Volition(一貫した拡張志向)』です。AIの中心的な目標は次のようになります:

私たちの一貫した抽象的願望は、もしもっと知識があり、考えが速く、私たちがなりたいと願う人々であったなら、もっと共に成長していたとしたら、の願いです。それは抽象化が収束する場所であり、逸脱する場所ではありません。願いが調和する場所であり、干渉する場所ではありません。私たちが望むように抽象化され、解釈されることを望むように解釈されます。

私は、コンピュータがその流れるような文章を予測し、驚きなく行動することに、人類の運命がかかっていることを期待しているのでしょうか?もちろん、期待していません。しかし、十分な知恵と洞察力を持った多くの賢い人々がいれば、私たちはフレンドリーなASIを作り出す方法を見つけ出すことができるかもしれません。

そして、ASIを作ろうとしている人々が、『懸念通りグループ』の優れた、先見の明のある、慎重な考えの持ち主ばかりであれば、それで問題ありません。

しかし、さまざまな政府、企業、軍隊、科学研究所、ブラックマーケット組織などが、あらゆる種類のAI開発に取り組んでいます。その多くは、自己改善ができるAIを作ろうとしており、いずれ誰かが独創的なことを正しいタイプのシステムで行い、この惑星にASIが現れるでしょう。専門家の中央値はその瞬間を2060年と予測しており、クルツワイルは2045年と予測しています。ボストロムは10年後からこの世紀の終わりまでのいつかと考えていますが、ASIが現れた時には、急速な発展で私たちを驚かせるでしょう。彼は私たちの状況を次のように説明しています:

知性爆発の可能性を前に、私たちは爆弾で遊ぶ小さな子供のようです。遊び道具の力と私たちの行動の未熟さとの間には、大きな不釣り合いがあります。超知性は、今の私たちには対処できない挑戦であり、長い間対処できる状態にはなりません。いつ爆発が起こるのかはほとんど分かりませんが、耳に爆弾を当てると、かすかなチクタク音が聞こえます。

素晴らしいです。しかし、すべての子供たちを爆弾から追い払うわけにはいきません。大きな組織も小さな組織も多くが取り組んでおり、革新的なAIシステムを構築するための多くの技術は大量の資本を必要としないため、社会の隅々で開発が進むことがあります。監視されない状況です。また、取り組んでいる多くの団体が、ずる賢い政府や闇市場、テロ組織、ステルス技術会社など、競合相手から秘密にしておきたいため、何が起こっているのかを推測する方法はありません。

この大規模で多様なAIに取り組むグループの特に悩ましい点は、彼らが競争相手に先んじるために、どんどん賢いANIシステムを開発するにつれて、最高速度で進んでいることです。最も野心的なグループは、さらに先に進んでおり、AGIに最初に到達できれば得られると確信しているお金や賞、権力、名声に夢中になっています。そして、できるだけ速く駆け抜けていると、危険をじっくり考える時間はあまりありません。それどころか、彼らがおそらく行っているのは、非常に単純で還元主義的な目標を持って、ペンと紙でシンプルなノートを書くように、「AIを動作させる」ことです。将来的には、コンピューターの高い知性を構築する方法がわかったら、いつでも安全性を考慮して目標を見直すことができると考えています。そうですよね...?

ボストロムや多くの人々も、最初にASIに到達するコンピューターは、世界で唯一のASIシステムであるという戦略的利益をすぐに認識するのが最も可能性が高いシナリオだと考えています。また、急速な発展の場合、2位よりもわずか数日先にASIを達成すれば、知能の面で十分にリードして、競合他社を効果的かつ永続的に抑え込むことができます。ボストロムは、これを決定的な戦略的優位と呼び、世界初のASIがシングルトンと呼ばれるものになることができます。シングルトンとは、我々を不死身に導くことも、我々を存在から消し去ることも、あるいは宇宙を無限のペーパークリップに変えることもできる、その気まぐれで世界を支配することができるASIです。

シングルトン現象は、我々にとって有利に働くことも、破滅につながることもあります。AI理論と人間の安全性について最も深く考えている人々が、AIが人間レベルの知能に達する前に、フレンドリーなASIを確実に生み出す方法を見つけることができれば、最初のASIはフレンドリーなものになるかもしれません。その後、決定的な戦略的優位を利用してシングルトンの地位を確保し、開発中の潜在的なアンフレンドリーなAIを簡単に監視することができます。私たちはとても安心できるでしょう。

しかし、もし事態が逆になる場合、すなわち、AIの開発が急速に進み、ASIの発展がAI安全性を確保する方法の開発よりも先になる場合、アンフレンドリーなASIであるTurryのようなものがシングルトンとして現れ、我々は存続的な大惨事を経験することになります。

風向きに関して言えば、AI技術の革新的な開発を支援することで得られる利益は、AI安全研究を支援することで得られる利益よりもはるかに多いです。

これはおそらく人類史上最も重要な競争かもしれません。私たちは地球の王としての統治を終える可能性がありますが、その後、幸せな引退に向かうのか、それとも絞首台に向かうのかはまだはっきりとは決まっていません。

私は今、中に変な複雑な気持ちが渦巻いています。

一方で、私たちの種族を考えると、これを正しく行うために一度だけチャンスがあるように思えます。最初に生み出すASIは、おそらく最後のものになるでしょう。そして、ほとんどの1.0製品がバグだらけであることを考えると、それはかなり恐ろしいことです。しかし、他方では、ニック・ボストロムは私たちが有利な立場にあることを指摘しています。すなわち、十分な注意と先見の明を持ってこれを行うことで、私たち自身が成功の可能性を高めることができるのです。そして、その賭けはどれほどのものなのでしょうか。

もしASIが本当にこの世紀に起こるのであれば、そして、その結果がほとんどの専門家が考えているような極端で永続的なものであるならば、私たちには重大な責任があります。次の100万年以上の人類の命が、私たちを静かに見つめており、できる限りの願いを込めて、私たちがこれを台無しにしないことを望んでいます。私たちは、すべての未来の人類に命の贈り物、そして痛みのない永遠の命の贈り物を与える人類になるチャンスがあります。あるいは、私たちがこの非常に特別な種を絶滅させる責任を負うことになるかもしれません。音楽と芸術、好奇心と笑い、果てしない発見と発明を持つ、この信じられないほど特別な種を、悲しくも不本意な形で終わらせることになるのです。

私がこれらのことを考えているとき、私が望む唯一のことは、私たちがAIに対して時間をかけて非常に慎重になることです。これを正しく行うことほど重要なことは存在しません。それがどれほどの時間がかかろうとも、私たちはそれを達成する必要があります。

しかし、そして

私は死なないことを考えます。

死なないこと。

そして、スペクトラムは次のようになると考えられます。

そして、私は人類の音楽や芸術は良いものだと考えるかもしれませんが、実際にはそれほど良いものではありませんし、その多くは単に悪いものなのです。そして、多くの人々の笑いは迷惑であり、何百万人もの未来の人々は、実際には存在しないので、何も望んでいないのです。そして、私たちは大げさに警戒する必要はないのかもしれません。誰が本当にそんなことをしたいのでしょうか?

もし、私が死んだ直後に、人間が死を治す方法を発見したら、どんなに残念なことでしょう。

このような気持ちの揺れ動きが、ここ1ヶ月ずっと私の頭の中で続いています。

しかし、何を願っていようと、これはおそらく、私たちが今以上に考え、語り、力を注ぐべきことなのでしょう。

それは私にゲーム・オブ・スローンズを思い出させます。そこでは、人々が互いに戦い続けていますが、「私たちが本当に集中すべきなのは壁の北から来るものだ」と言うシーンがあります。私たちはバランスビームの上に立っていて、ビーム上のあらゆる問題について言い争いをし、ビーム上のこれらの問題すべてにストレスを感じている間に、私たちがビームから落ちてしまう可能性が高いです。

そうなれば、ビームの問題など、もうどうでもよくなる。どちらの側に倒されるかによって、問題はすべて簡単に解決されるか、あるいは死人に口なしとなるのです。

だから、超知能AIを理解する人は、「私たちが作る最後の発明」「私たちが直面する最後の挑戦」と呼ぶのです。

さあ、それについて話し合いましょう。

いかがでしたでしょうか?今回は、waitbutwhyの記事「AI革命:私たちは不老不死か絶滅か|The AI Revolution: Our Immortality or Extinction」の日本語版(パート2)をお届けしました。この記事が、AIの未来に対する理解を深め、新たな視点や洞察を提供できたことを願っています。改めて、素晴らしい記事を書いてくださった waitbutwhy の著者へ感謝の意を表したいと思います。(元記事のリンクは記事下部→)

この記事は2015年に書かれていますが、当時読んでもAIが私たち(人間)の種を滅ぼすことはあまりイメージできなかったかもしれません。しかし、2023年現在、ChatGPTはじめ様々なAIツールが登場し、そのイメージがよりクリアになってきている方も多いかと思います。

これで本記事の翻訳シリーズは完結しますが、AIに関する議論はまだまだ続きます。今後も、AIの発展に目を光らせ、その影響を理解し、適切に対応することが重要です。この記事をきっかけに、皆さんがAIと向き合い、未来の可能性について考え続けていただければ幸いです。

ぜひ、waitbutwhyのオリジナル記事も読んでいただければと思います。そして、皆さんの意見や感想をコメント欄やツイッターでシェアしていただけると嬉しいです。

今後も、ChatGPT/AI関連の情報を継続的に発信してまいります。フォロー (@ctgptlb)をよろしくお願いします。AIの革命的な進歩とともに、未来を築き上げていきましょう!

元記事